新型AI将照片转化为可直接模拟的3D物体

从平面照片到功能性3D模型

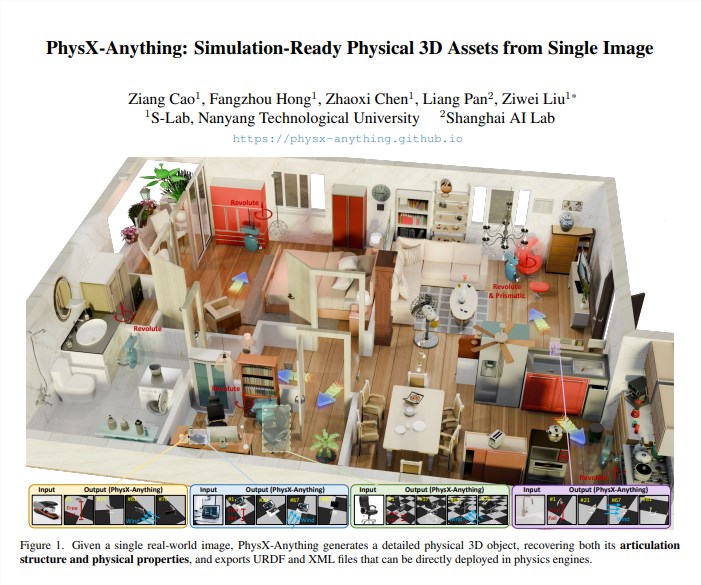

想象一下:给椅子拍张照,就能立即获得行为与实物完全一致的数字化版本——包括正确的重量分布、可活动部件和真实物理特性。这正是PhysX-Anything实现的功能。这项由南洋理工大学与上海人工智能实验室联合开发的突破性技术,填补了计算机视觉与物理模拟之间的鸿沟。

工作原理

该系统采用巧妙的两步法:首先分析物体的整体物理属性(如质量分布和表面摩擦),然后聚焦细化各组件及其运动范围。这避免了视觉精确的模型在模拟中行为异常的常见问题。

PhysX-Anything的真正优势在于其高效编码方法——将所有必要信息(形状、关节、物理特性)打包成紧凑的数字包,使用时能快速重建。这使得该过程比当前最先进方法快约两倍。

实际表现

测试结果令人印象深刻:

- 几何精度提升18%

- 物理误差减少27%

- 尺寸误差控制在2厘米内

- 关节运动精度达5度以内

应用于机器人训练模拟时效果更显著:

- 抓取成功率跃升12%

- 所需训练时间减少近三分之一

研究团队使用从宜家家具到厨房用具的日常物品验证了这些改进。

开放共享的未来

研究人员已公开所有资源——代码、训练模型、数据集——希望加速该领域发展。他们正在开发2.0版本,将支持视频输入以捕捉物体随时间运动的状态。

对机器人专家和游戏开发者而言,这项技术能极大简化真实物体的数字孪生创建过程。无需再手动精细建模每个物理属性,未来可能只需拍照即可获得可运行的模拟模型。

其影响不仅限于机器人领域——建筑师测试家具布局、产品设计师用现有物品照片作为起点进行原型设计都将成为可能。

核心要点:

- 将单张图像转化为可直接模拟的3D资源

- 同时保留视觉外观与物理行为特性

- 开源框架已在GitHub发布

- 支持视频输入的版本将于明年初推出