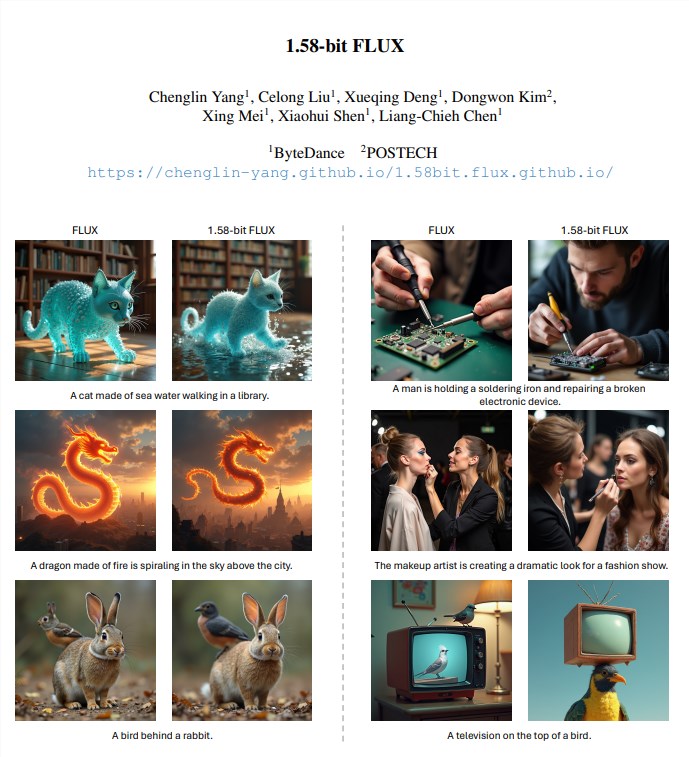

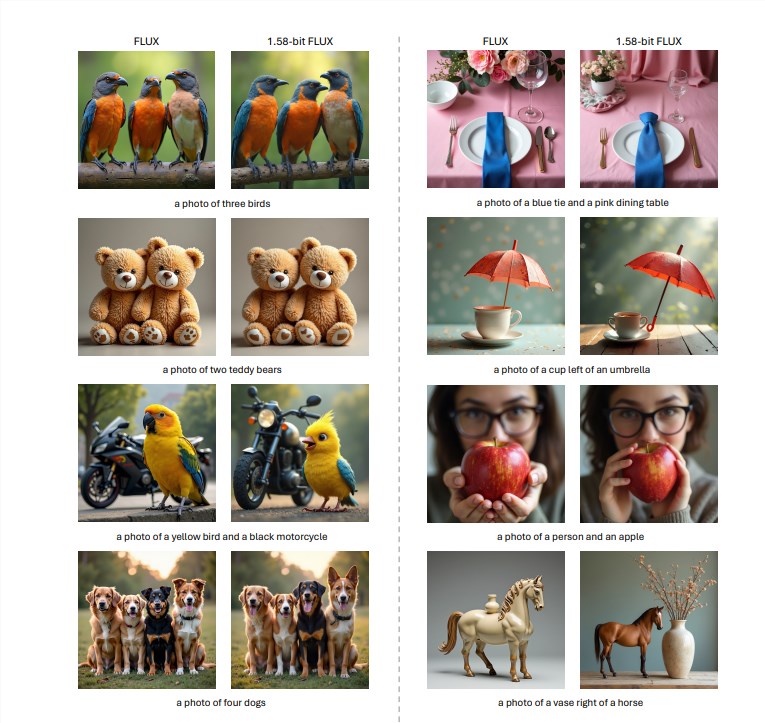

BytePush 发布 1.58 位 FLUX 模型以提高 AI 效率

BytePush 发布 1.58 位量化 FLUX 模型

介绍

人工智能 (AI) 驱动的文本到图像 (T2I) 生成模型如 DALLE3 和 Adobe Firefly3 展现了卓越的能力,但它们的庞大内存需求为在资源有限的设备上部署带来了挑战。为了克服这些障碍,字节跳动和 POSTECH 的研究人员推出了一种 1.58 位量化 FLUX 模型,显著减少了内存使用同时提升了性能。

资源限制的挑战

T2I 模型通常包含数十亿个参数,使其不适合移动设备和其他资源受限的平台。低位量化技术的探索对于使这些强大的模型在现实应用中更易获取和高效至关重要。

研究方法

研究团队专注于 FLUX.1-dev 模型,该模型是公开可用的并以其性能而闻名。他们应用了一种新颖的 1.58 位量化 技术,将视觉变换器权重压缩为仅三种不同的值:{-1, 0, +1}。该方法不需要访问图像数据,仅依赖于模型的自我监督。与 BitNet b1.58 方法不同,它需要从头开始训练大型语言模型,这种后训练量化解决方案优化了现有的 T2I 模型。

主要改进

使用这种 1.58 位量化方法,研究人员实现了 7.7 倍的存储空间减少。压缩后的权重以 2 位有符号整数的形式存储,过渡到标准的 16 位精度。此外,实施了为低位计算设计的自定义内核,这使得推理内存使用减少了超过 5.1 倍,并提高了推理速度。

对包括 GenEval 和 T2I Compbench 在内的既定基准的评估表明,1.58 位 FLUX 模型不仅保持了与全精度 FLUX 模型相当的生成质量,还增强了计算效率。

性能指标

研究人员量化了高达 99.5% 的视觉变换器参数,总计达到 11.9 亿 个参数在 FLUX 模型中。实验结果显示,1.58 位 FLUX 在 T2I CompBench 和 GenEval 数据集上的性能与原始模型相似。值得注意的是,该模型在较低性能 GPU 上(如 L20 和 A10)在推理速度上表现出更显著的改进。

结论

1.58 位 FLUX 模型 的发布代表了在内存和延迟受限设备上部署 T2I 模型的重大进展。尽管在速度提升和高分辨率图像渲染方面存在一些限制,但该模型在提高效率和减少资源消耗方面的潜力对未来的 AI 研究具有前景。

要点

- 模型存储空间减少了 7.7 倍。

- 推理内存使用降低了超过 5.1 倍。

- 在基准测试中,与全精度 FLUX 模型相比,性能保持在相似水平。

- 量化过程不需要访问任何图像数据。

- 为低位计算优化的自定义内核提高了推理效率。