DeepSeek的记忆增强:AI模型如何变得更智能

DeepSeek的突破使AI更高效

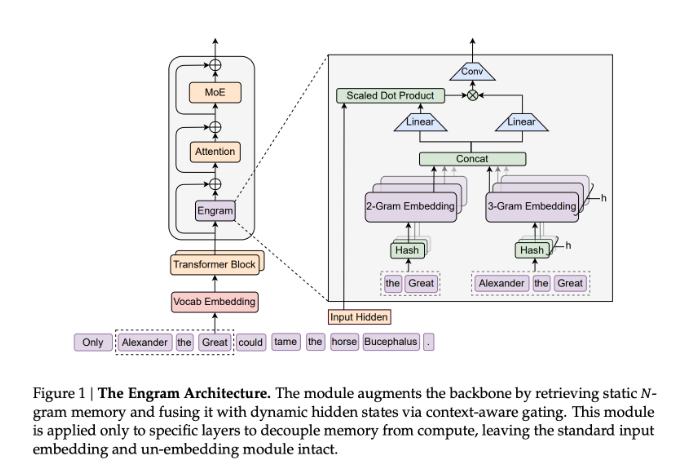

想象一个不断忘记简单事实、需要反复查找的助手——这基本上就是当今AI模型的运作方式。DeepSeek的新Engram模块通过赋予人工智能类似人类记忆的功能改变了这一现状。

解决AI的健忘问题

传统的Transformer模型浪费能量反复重新计算相同信息。“这就像每次去商店都要从头重建购物清单,”一位熟悉该项目的研究人员解释道。Engram模块通过为常用知识创建专门的记忆通道来解决这个问题。

与试图取代现有架构的类似系统不同,Engram与它们协同工作。它将古老的N-gram技术现代化为一个可扩展的查找系统,以闪电般的速度运行——在恒定时间内检索信息(对技术精通的读者来说是O(1)复杂度)。

现实世界中的性能提升

DeepSeek团队使用包含2620亿个token的大规模数据集对Engram进行了严格测试。结果引人注目:

- 将20-25%容量分配给Engram的模型显示出显著提高的准确性

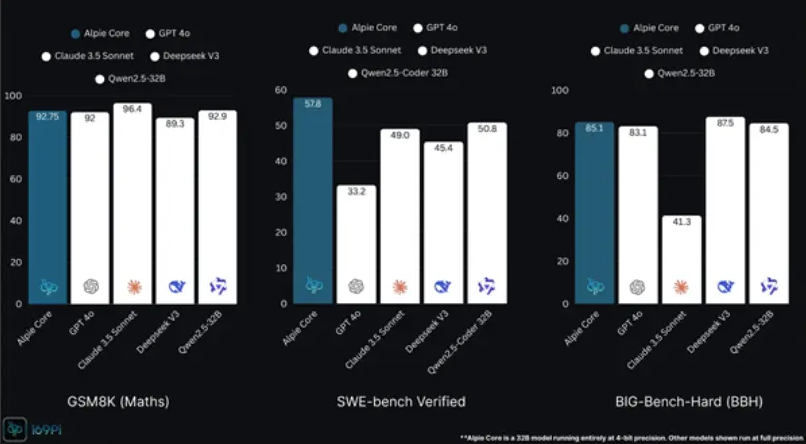

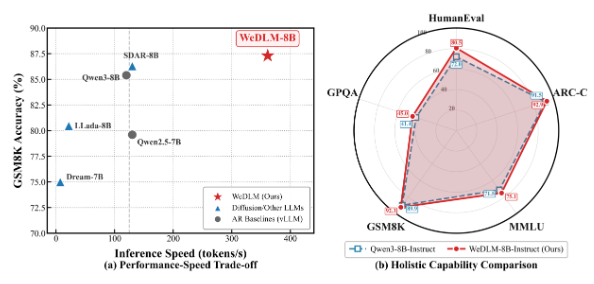

- 270亿和400亿参数版本在各种基准测试中均优于传统模型

- 该系统尤其在数学、编码任务和常识测试中表现出色

这项创新在处理长文档时表现最为突出。在上下文窗口扩展到32,768个token(约50页文本)的情况下,配备Engram的模型在查找特定信息时保持了令人印象深刻的准确性——就像在数字干草堆中找到针一样。

为何这不仅关乎基准测试分数

Engram的特殊之处不仅在于更好的测试分数。通过卸载常规记忆任务,该系统有效地赋予AI模型更深层次的思考能力,而无需更多计算能力。这类似于释放心智RAM,使系统能够解决更棘手的问题。

这项技术可能带来:

- 能记住用户偏好的响应更快的聊天机器人

- 能够处理冗长文档的更快速研究助手

- AI服务的能耗降低

DeepSeek团队继续完善Engram,但早期结果表明我们正在见证迈向更高效人工智能的重要一步。

关键点:

- 记忆升级:Engram为存储常识创建专门路径,同时保留推理能力

- 性能提升:测试模型在数学(GSM8K)、常识(MMLU)和编码任务中表现出改进

- 长文档处理大师:即使在处理相当于50多页文本的内容时,系统仍保持准确性

- 节能高效:通过消除冗余计算,相同的计算能力提供更智能的结果