字节跳动发布Sa2VA:融合LLaVA与SAM-2,实现AI驱动的视频分割技术

字节跳动发布Sa2VA:多模态AI分割技术的重大突破

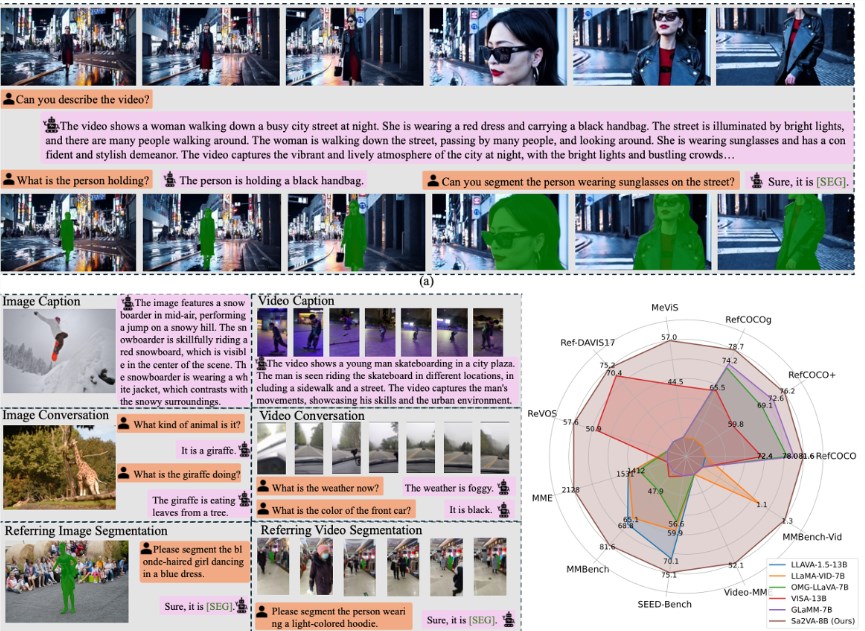

在人工智能技术的重大飞跃中,字节跳动与学术研究人员合作开发了Sa2VA——这一新颖模型融合了两大强力AI系统的优势:LLaVA(大型语言视觉助手)和SAM-2(万物分割模型)。这种创新组合创造了一个能实现复杂视频理解与精确物体分割的多模态解决方案。

连接两大AI巨头

新模型解决了现有技术的关键局限。LLaVA虽然擅长宏观层面的视频叙事与内容理解,但在细节执行任务上存在不足;而SAM-2精于像素级图像分割却缺乏语言处理能力。Sa2VA通过创新的"编码"系统有效弥合了这一鸿沟,实现了两个组件间的无缝通信。

"可以将Sa2VA视为拥有双处理器,"项目首席研究员李翔博士解释道,"一个模块专精语言理解与对话处理,另一个则负责精确的视频分割与物体追踪。"

Sa2VA背后的技术创新

该模型通过优雅的工作流程运行:

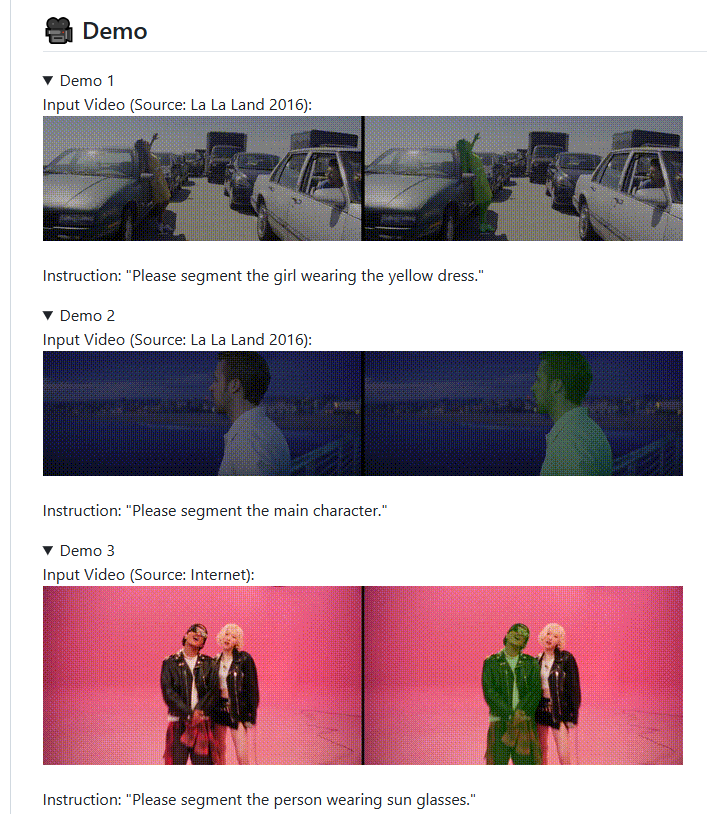

- 用户提供自然语言指令

- LLaVA组件解析这些命令

- 生成专用指令令牌

- SAM-2接收这些令牌执行精确分割

- 持续反馈优化未来表现

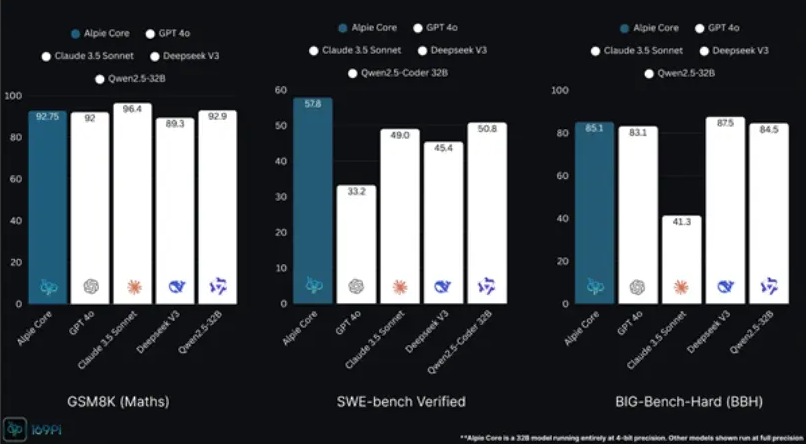

研究团队采用多任务联合训练来增强Sa2VA在多领域的性能。初期测试显示出卓越表现,尤其在以下方面:

- 视频参照分割

- 实时物体追踪

- 复杂场景理解

- 动态视频处理

开源承诺与未来应用

字节跳动已公开多个Sa2VA版本及完整训练工具:

这种开放态度旨在加速多模态AI技术在各个行业的应用发展,包括:

- 自动驾驶汽车

- 医学影像

- 内容审核

- 增强现实

此次发布延续了字节跳动在开源AI发展中的贡献模式,同时为其商业产品(如TikTok)保留专有增强功能。

核心要点:

- 多模态突破:Sa2VA结合了LLaVA的语言理解能力与SAM-2的分割精度。

- 实际表现:在动态物体追踪等复杂视频分析任务中表现优异。

- 开放生态:公开可用模型促进广泛研究与应用开发。

- 未来潜力:该技术可应用于需要高级视觉分析的众多行业。