小型AI模型凭借新型训练方法超越大型模型

小型AI模型凭借新型训练方法超越大型模型

当追求更大AI模型的竞赛使得计算成本变得难以承受时,一项名为"策略蒸馏"的突破性技术正在改变游戏规则。由前OpenAI首席技术官Mira Murati领导的Thinking Machines实验室开发的这种方法,使小型模型能以极低成本达到以往只有大型系统才能实现的性能水平。

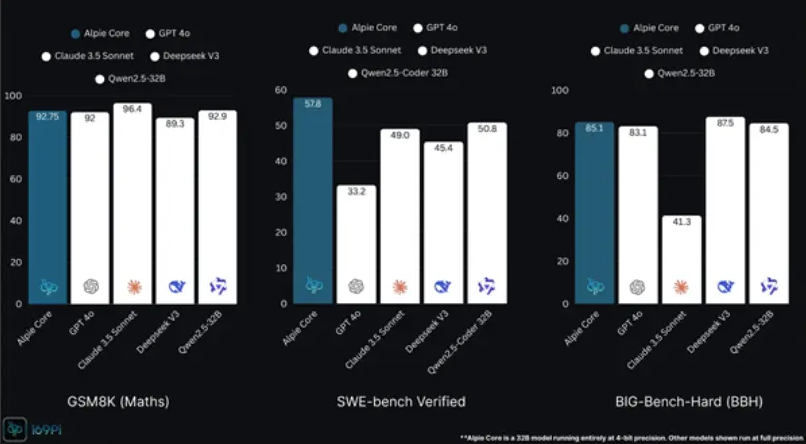

效率突破:80亿参数模型媲美320亿参数性能

最新研究表明,采用策略蒸馏训练的80亿参数模型可达到320亿参数模型70%的性能。训练成本下降90%,而效率提升50至100倍。这一进展或将实现AI开发的民主化,使中小企业和个人开发者也能训练具有竞争力的专业模型。

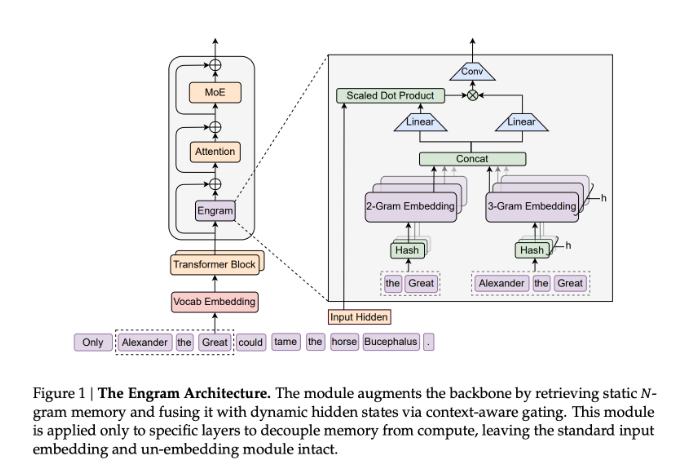

工作原理:实时反馈革新训练过程

关键创新在于"逐标记密集反馈"机制。与传统强化学习(RL)在每轮结束时提供稀疏奖励不同,策略蒸馏允许教师模型对学生模型生成的每个标记提供实时评分。这种持续指导能够:

- 加速收敛速度

- 防止长序列训练中的"策略漂移"

- 确保小型模型持续输出高质量结果

实际测试中,Qwen3-8B模型仅用150次训练步骤就在数学推理任务上达到70%准确率,而传统RL方法需要17,920 GPU小时才能获得类似结果。

解决灾难性遗忘:学习新技能时保留旧知识

AI领域长期存在"灾难性遗忘"难题——即模型在学习新知识时会遗忘已掌握能力。传统微调方法在整合新文档时,指令跟随能力可能从85%骤降至45%。

策略蒸馏通过以下方式解决该问题:

- 实时轨迹采样

- 渐进式教师校正

该方法在保留41%新知识的同时,能快速将原始能力恢复至83%,显著优于传统方法。

实施方案:简单四步流程

该方法的轻量级架构仅需四个重复步骤:

- 部署教师模型(如320亿参数)作为监督源

- 学生模型生成响应轨迹

- 教师计算每个标记的对数概率

- 使用反向KL散度优化学生参数

该系统兼容现有蒸馏框架,无需复杂基础设施即可实现研究人员所称的"高性价比精准"性能飞跃。

AI民主化的深远影响

Murati的方法被行业专家称为"降维打击"——通过更智能的训练方法而非单纯增加参数规模来实现突破。这带来重大影响:

- 使高性能AI可在移动和物联网设备上运行

- 减少对云端"AI垄断"的依赖

- 实现无能力损失的持续模型进化

该技术对企业应用尤其具有前景——这些场景需要模型动态学习业务规则,同时不牺牲基础对话和工具调用等核心功能。

关键要点:

- AI训练成本降低90%

- 小型(80亿)模型达到大型(320亿)模型70%性能

- 解决灾难性遗忘同时吸收新知识

- 简单实施且兼容现有框架

- 有望推动跨行业AI开发民主化