Llamafile 0.9.3 新增通义千问3支持,简化AI部署流程

Mozilla旗下的开源项目Llamafile发布了0.9.3版本,在大语言模型可访问性方面取得重大进展。本次更新引入了对阿里云通义千问3系列的支持,标志着简化AI部署迈出重要一步。

单文件革命 Llamafile的突破性在于其单可执行文件设计,结合了llama.cpp的推理能力和Cosmopolitan Libc的跨平台功能。这种创新方法将模型权重、推理代码和运行时环境打包成一个文件,可在Windows、macOS、Linux、FreeBSD、OpenBSD和NetBSD上运行而无需复杂安装。

新版本支持多个通义千问3模型,包括300亿参数的Qwen3-30B-A3B,以及更小型的Qwen3-4B和Qwen3-0.6B变体。这些模型以GGUF格式存储并经过量化优化,可在消费级硬件上高效运行——Qwen3-30B-A3B仅需16GB内存即可流畅运行。

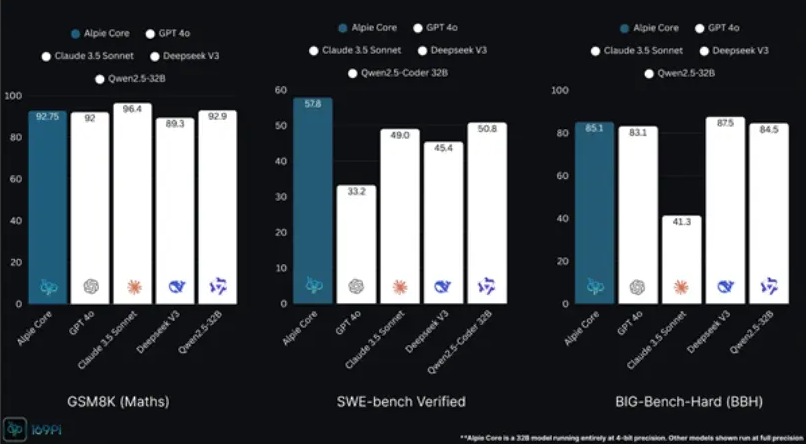

性能提升 通义千问3在编码、数学和多语言处理(支持119种语言)方面带来显著改进。通过llama.cpp更新(版本b5092+)实现的集成支持混合CPU/GPU推理,提供2至8位量化选项大幅降低内存需求。基准测试显示量化后的Qwen3-4B在标准笔记本电脑上每秒可生成超过20个token。

通用兼容性 Cosmopolitan Libc通过动态运行时调度实现真正的跨平台运行,适配多种CPU架构(x86_64和ARM64)和现代指令集(AVX、AVX2、Neon)。开发者只需在Linux中编译一次即可获得通用兼容性——测试证实即使是树莓派设备也能以实用速度运行较小的通义千问3模型。

该软件包包含Web GUI聊天界面和OpenAI兼容API端点。用户可通过简单命令如./llamafile -m Qwen3-4B-Q8_0.gguf --host 0.0.0.0启动本地服务器,并通过浏览器在localhost:8080访问聊天功能。

生态发展 除通义千问3支持外,0.9.3版本还新增Phi4模型兼容性并将LocalScore基准测试工具性能提升15%。更新整合了llama.cpp的最新优化,包括增强的矩阵乘法内核和对新架构的支持。

基于Apache2.0许可证发布的Llamafile鼓励社区开发。模型可从Hugging Face下载(Qwen3-30B-A3B为单个4.2GB文件),并可通过zipalign工具或与Ollama、LM Studio等平台集成进行定制。

行业影响 此版本显著降低个人开发者、中小企业和教育机构的本地AI实施门槛,同时解决云解决方案固有的隐私问题。该技术在教育、医疗和物联网等需要离线操作的领域展现出特殊潜力。

虽然当前主要针对中型模型(约300亿参数以下)优化,但未来发展可能解决如Qwen3-235B等大型架构在文件大小管理和内存优化方面的挑战。

项目地址:https://github.com/Mozilla-Ocho/llamafile

关键要点

- 单文件部署消除六大操作系统上的复杂设置

- 支持多个通义千问3变体包括强大的300亿参数模型

- 通过量化实现在消费级硬件上的实用性能

- 借助Cosmopolitan Libc实现"一次编译处处运行"功能

- 包含用户友好界面(Web GUI和OpenAI兼容API)