Yuchu新型AI模型赋予机器人常识

开源AI大脑让机器人更聪明

想象一个不仅能盲目遵循指令,还能理解物体在空间中如何移动的机器人——知道抓握杯子的哪个位置不会滑落,开门时该用多大的力道。这正是Yuchu新推出的UnifoLM-VLA-0模型为人形机器人带来的能力。

从屏幕智能到街头智慧

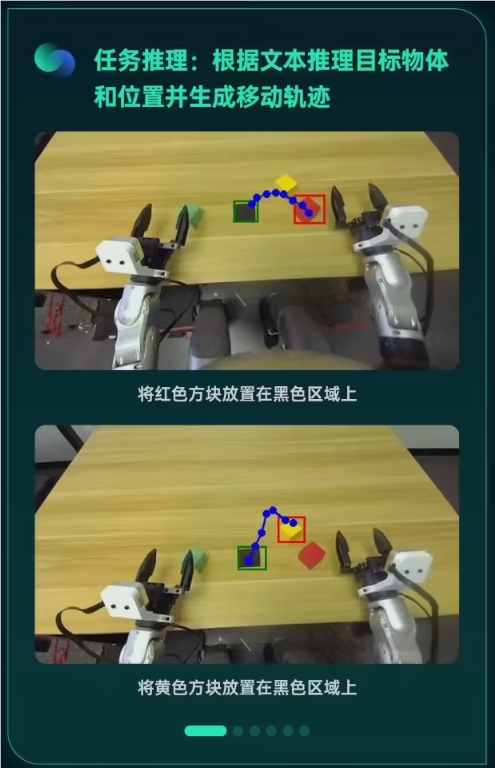

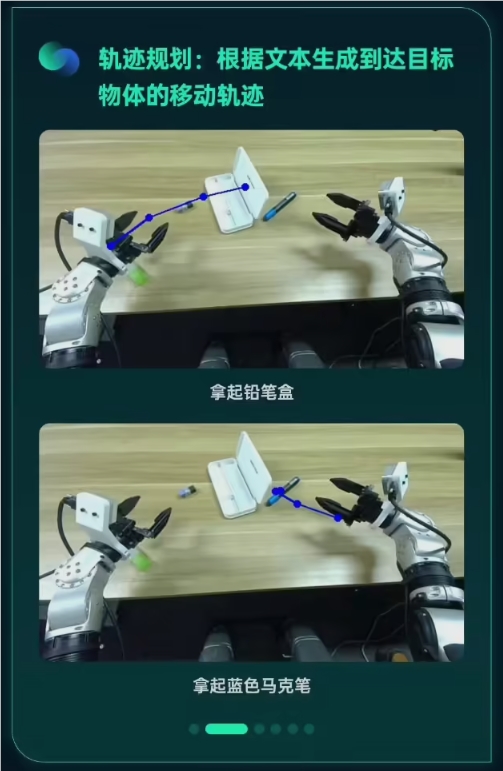

重大突破何在?这不是另一个仅通过文本来假装理解世界的聊天机器人。UnifoLM-VLA-0真正掌握了物理现实:

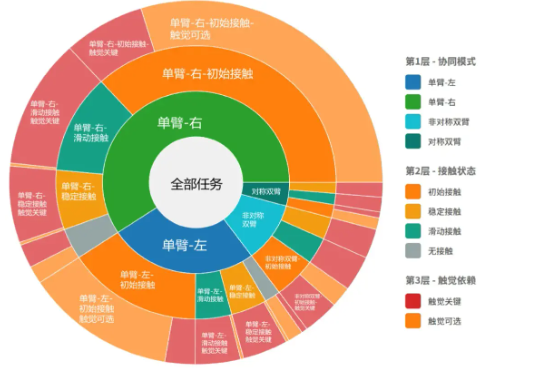

- 空间直觉:像人类本能那样将文本指令与3D环境对齐

- 动作规划:在考虑真实世界物理规律的同时预测动作序列

- 适应性:即使在任务中被碰撞或打断也能保持稳定

巧构而非蛮建

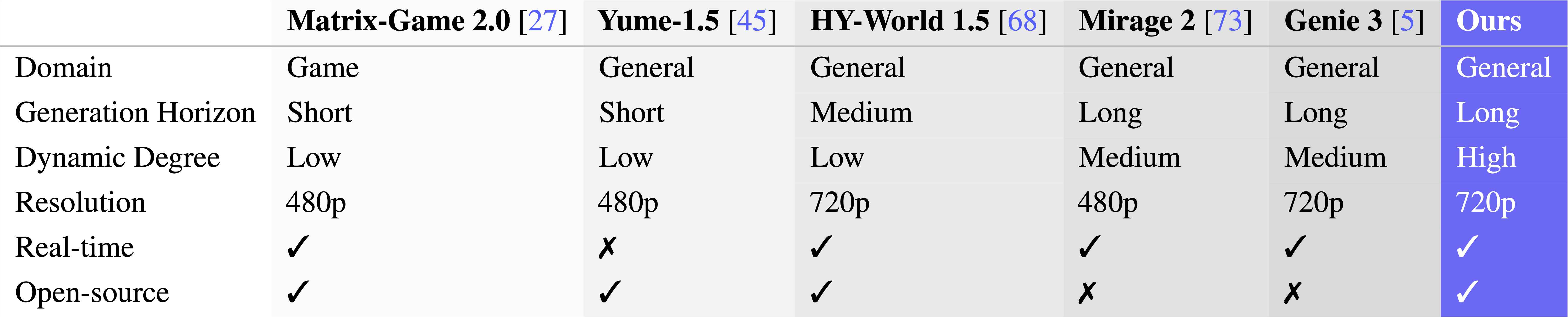

Yuchu并未从零开始。他们在阿里巴巴Qwen2.5-VL模型的坚实基础上进行了强化:

- 仅用340小时真实机器人数据训练——对此类能力而言出奇高效

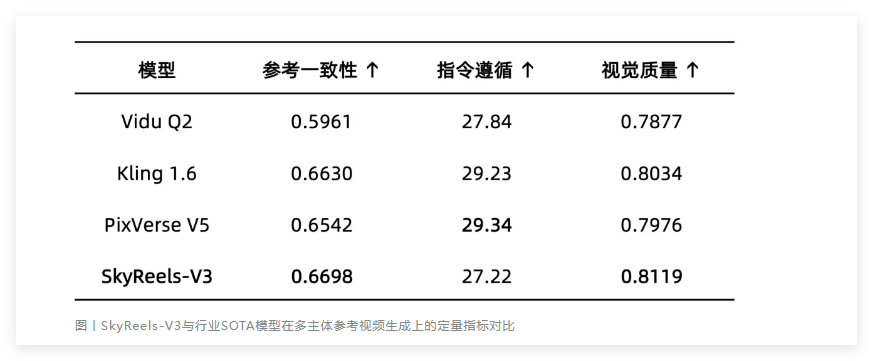

- 在空间推理测试中显著超越其父模型

- 在某些场景下直逼谷歌Gemini-Robotics

秘诀何在?一个专注于物理交互而非抽象知识的精细清洗数据集。

真实世界的机器人验证

橡胶与路面相遇于Yuchu的G1人形平台,在这里UnifoLM-VLA-0能够处理:

- 精确物体操控(不再笨手笨脚打翻咖啡杯!)

- 无需重新编程的复杂多步骤任务

- 意外干扰而不会导致灾难性失败

关键要点:

- 开放获取:完整模型现已发布于GitHub供全球开发者使用

- 物理智能:标志着从纯认知到具身理解的转变

- 商业潜力:可能加速服务机器人的实际应用

- 社区益处:开源方式邀请全球协作开发机器人大脑