延世大学深陷AI作弊丑闻:逾半数学生被曝使用ChatGPT

韩国名校陷入AI作弊风暴

首尔——延世大学一场常规在线考试演变成了韩国近年来最严重的学术诚信事件。在这门颇具讽刺意味的《自然语言处理与ChatGPT》课程中,教授发现涉及600名注册学生中超半数的广泛作弊行为。

完美作弊温床

10月15日举行的在线期中考试初看防护严密:要求学生全程录制电脑屏幕、手部及面部图像。但正如一名学生匿名坦承:「我们找到了所有监控的漏洞。」

有人巧妙调整摄像头角度制造盲区,另有人同时运行多个窗口隐藏操作。选择题形式尤其诱使学生寻求AI工具快速获取答案。

如潮水般的自白

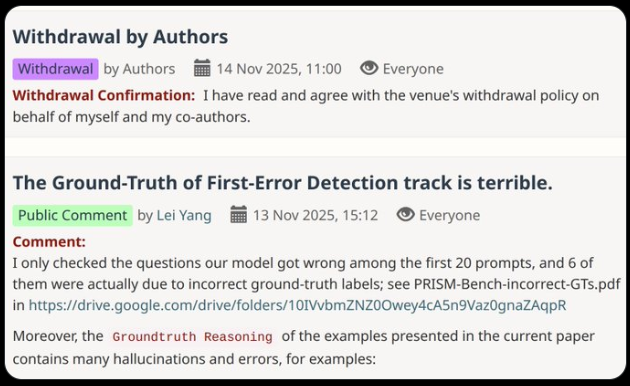

当怀疑产生时,教授采取了非常规手段——承诺对坦白者宽大处理。结果令人震惊:在社交平台"Everytime"的匿名调查中,353名受访者有190人承认作弊。

「考试期间大多数人都在用ChatGPT」,一名学生直言不讳。另一人补充道:「用AI查答案已成常态。」

校方对确认案例采取零容忍政策,作弊者直接判不及格。但如此规模的事件已非个别不当行为——而是现代教育面临的系统性挑战。

政策真空遭遇技术革命

这场丑闻暴露出韩国高等教育体系的明显缺陷。根据2024年韩国职业能力研究院调查,虽然91.7%的学生承认学术中使用AI工具,但71.1%的大学尚未建立正式的生成式AI使用规范。

「我们正在追赶」,教育政策专家朴敏智博士坦言,「技术发展速度远超我们的监管能力」。

未来何去何从?

延世事件引发紧迫议题:

- 大学如何为AI时代重构考核方式?

- 是否应教授伦理化AI使用而非全面禁止?

- 当ChatGPT等工具模糊界限时,何种协助构成正当而非作弊?

正如一名延世学生的忏悔:「我们都知道不对,但当所有人都在做...」这记警钟或许能唤醒学术界直面科技与诚信的棘手真相。

关键点:

- 规模惊人:可能涉及300+名学生作弊事件

- 监控漏洞:学生利用监考系统技术缺陷

- 政策缺失:多数韩高校缺乏明确AI使用指南

- 文化转变:学生普遍将AI辅助作弊视为"常态"

- 深层影响:迫使重新评估数字时代的考核体系