清华新工具简化音频AI评估

清华研究人员推动音频AI评估民主化

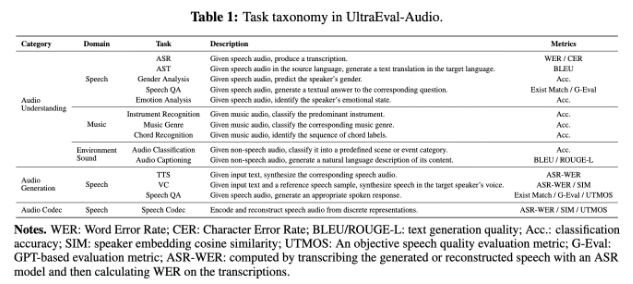

在音频AI领域的重要进展中,清华大学NLP实验室与OpenBMB和Miga Intelligence合作发布了UltraEval-Audio——一个正在改变研究人员评估音频模型方式的开源框架。这不仅是一个技术工具,更是为开发语音助手到播客转录服务等应用的开发者带来的潜在变革者。

最新发布的v1.1.0版本包含多项实用升级:

- 一键模型复现功能让研究人员快速复制热门音频模型

- 扩展的支持范围涵盖文本转语音(TTS)和自动语音识别(ASR)等专业领域

- 新增的隔离推理操作使评估更具可控性和便携性

"最让我们兴奋的是它如何降低门槛",清华大学NLP实验室的李伟博士解释道,"以往评估不同音频模型需要搭建多重环境——现在研究人员可以专注于创新而非基础设施"。

该框架已证明其价值,成为MiniCPM-o2.6和VoxCPM等有影响力模型的评估标准。其开源特性意味着任何开发者都能通过GitHub获取这些专业级工具。

超越学术界的意义

虽然技术细节看似小众,但其影响远超大学实验室:

- 加速创新周期:缩短的评估时间意味着日常使用的语音技术能更快迭代

- 标准化基准:为比较不同方法建立共同基础

- 资源效率:小团队也能实现以往需要重大基础设施才能完成的工作

GitHub仓库(https://github.com/OpenBMB/UltraEval-Audio)显示社区参与度持续增长,全球开发者正共同推动其演进。

核心要点:

- 🎯 简化评估:UltraEval-Audio提供标准化工具用于评估音频AI模型

- ⚡ 实用升级:1.1.0版本新增一键复现和更广泛的模型支持

- 🌍 开放获取:通过GitHub向全球研究社区开放

- 🚀 现实影响:已被主流音频AI项目采用