清华与快手突破性成果:SVG模型将AI训练效率提升6200%

革命性AI模型打破效率壁垒

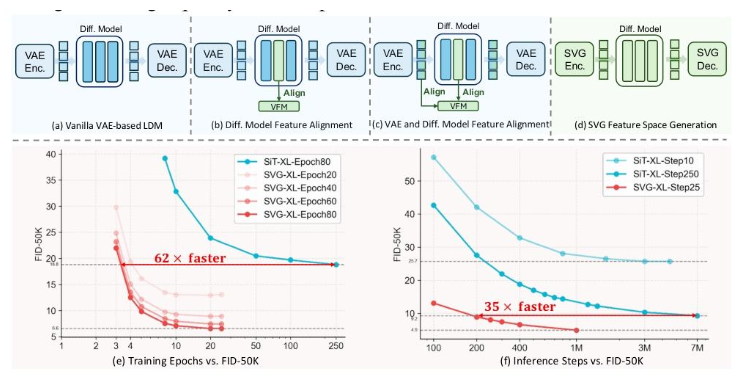

在一项里程碑式的合作中,清华大学与快手灵犀团队发布了SVG(无VAE的潜在扩散模型),标志着生成式AI技术可能的范式转变。他们的突破解决了当前变分自编码器(VAE)系统的根本局限,同时带来了前所未有的性能提升。

传统VAE模型的衰落

VAE技术日益受到"语义纠缠"问题的困扰——修改一个图像特征会无意中改变不相关的特性。这种现象在进行针对性编辑时会产生扭曲的输出(例如改变猫的颜色同时保留其表情)。

SVG背后的架构创新

研究团队实现了三项关键技术突破:

- 语义提取:采用DINOv3预训练模型通过大规模自监督学习实现精确特征分离

- 细节保留:设计了轻量级残差编码器以保持精细视觉元素而不受语义干扰

- 特征融合:开发了新颖的分布对齐机制确保语义和细节特征的和谐集成

该方法从根本上重新思考了潜在空间的构建,消除了生成质量与计算效率之间的妥协。

超越基准的性能表现

SVG模型在多项指标上展现出非凡能力:

- 仅经过80次训练周期就在ImageNet上达到FID分数6.57(通常需要数百次)

- 需要更少的采样步骤同时保持卓越的图像清晰度

- 可直接应用于下游任务(分类、分割)而无需微调

- 在多模态生成场景中表现出强大的泛化能力

论文揭示了与传统方法相比尤为令人印象深刻的对比:

| 指标 | SVG改进 |

|---|

未来影响与可用性

这一技术飞跃有望在以下领域带来变革性应用:

- 实时内容生成平台

- 专业创意工具

- 自动化视觉设计系统 详细记录这些发现的研究论文已在arXiv公开。

关键点:

- SVG模型消除了VAE的语义纠缠限制

- 将DINOv3语义提取与新颖的残差编码相结合

- 在速度和效率上实现了数量级的改进

- 保持与现有工作流的向后兼容性

- 为实时生成应用开辟了新可能性