微型AI模型实力惊人,性能超越巨头

小模型大影响:Liquid AI的最新突破

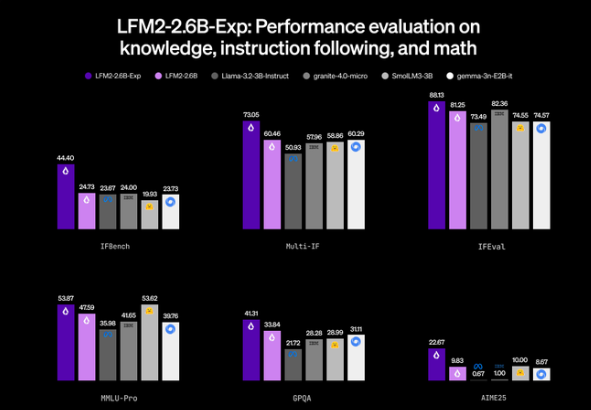

在令人意外的节日公告中,边缘AI初创公司Liquid AI于圣诞节当天发布了实验性LFM2-2.6B-Exp模型。此次发布的非凡之处不在于其规模——26亿参数按当今标准堪称娇小——而在于其超常表现正在挑战体型更大的竞争对手。

重塑强化学习

成功秘诀?纯粹的强化学习(RL)优化,摒弃了常见的监督微调或教师模型蒸馏等辅助手段。这种精简方法基于Liquid AI第二代混合架构,巧妙结合了短程门控卷积与分组查询注意力(GQA)。结果如何?一个精悍的推理机器,既能处理长达32K的上下文,又灵活适用于智能手机和物联网设备。

"我们对它在智能体工作流和创意应用方面的潜力尤为兴奋,"Liquid AI发言人表示。该模型在RAG检索、数据提取和出人意料流畅的多轮对话中表现突出。

打破基准的性能

数据讲述着令人印象深刻的故事:

- 指令遵循:让参数多263倍的DeepSeek R1-0528望尘莫及

- 研究生级知识:得分约42%,令传统30亿参数模型相形见绌

- 数学推理:以82%的成绩超越Llama3.23B和Gemma3系列

最惊人的是?它在标准CPU上处理信息的速度是对手的两倍,同时功耗堪比节能手机应用。

边缘AI民主化

秉承节日馈赠精神,Liquid AI已将LFM2-2.6B-Exp在Hugging Face上完全开源。此举可能大幅加速边缘AI普及——想象研究助手级别的智能本地运行于手机,既不耗电又保护隐私。

潜在影响令人振奋:如果小模型能通过智能训练(而非暴力扩展)实现此等性能,我们或许正进入一个强大AI舒适装入衣袋的新时代,无需依赖庞大云基础设施。

关键要点:

- 26亿参数的微型模型超越数百倍规模的巨头

- 采用纯强化学习,摒弃传统训练方法

- 擅长指令遵循、知识问答和数学推理

- 处理速度两倍于竞品且内存占用极低

- 完全开源并针对边缘设备部署优化