微型AI大脑装入口袋:Liquid AI突破性模型可在手机上运行

Liquid AI为智能手机注入强大脑力

想象拥有一个不仅能聊天、更能像人类一样思考问题的AI助手——而且可以轻松放入口袋。这正是Liquid AI通过其突破性新模型实现的愿景。

小巧体积 惊人智慧

LFM2.5-1.2B-Thinking模型代表着边缘计算的重大飞跃。当其他公司追逐需要庞大算力的超大规模语言模型时,Liquid AI反其道而行——将复杂的推理能力浓缩至智能手机尺寸。

开发团队解释道:"我们并非要重建通用对话,而是聚焦于打造一个擅长逻辑推理和问题解决,同时保持足够精简以适应移动设备的AI"。

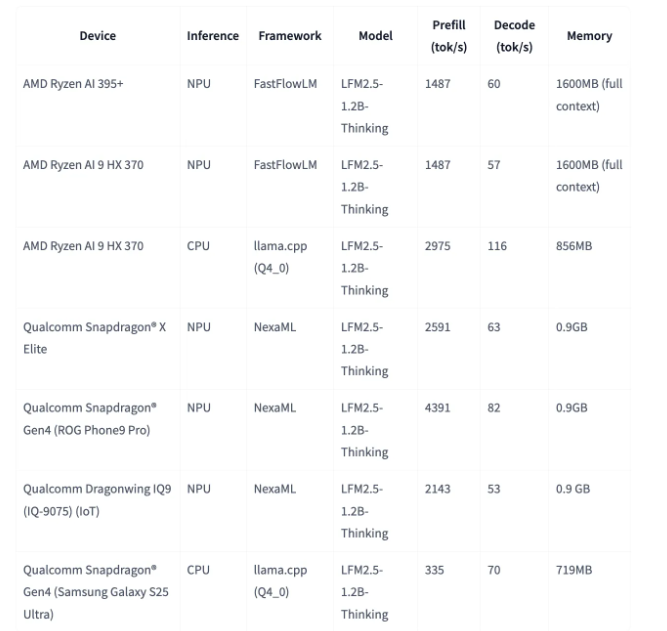

数据说明一切:

- 900MB内存占用——比多数手机游戏更小

- 239字符/秒在AMD CPU上的处理速度

- 82字符/秒即使在移动NPU上也能保持

模拟人类思考方式

该模型的独特之处在于其解题方式。不同于直接输出答案,LFM2.5会生成内部"思考轨迹"——实质上是在呈现结论前展示其推导过程。

这种方法映射了人类认知:

- 将复杂问题分解为步骤

- 验证中间结果

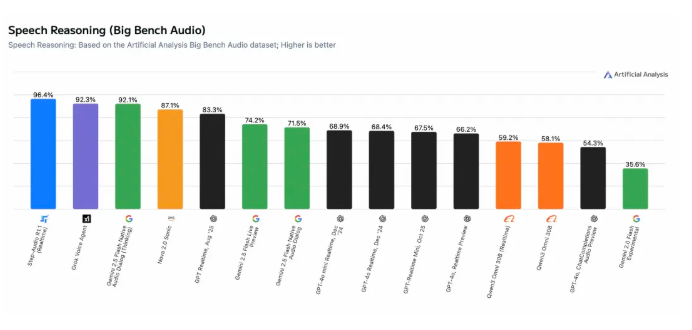

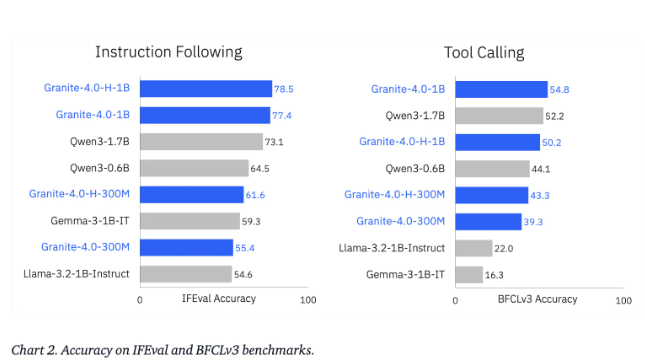

- 必要时调整方向 效果如何?准确率令竞争对手望尘莫及。

破解循环卡死难题

团队直面AI最令人沮丧的特性之一:那些模型陷入无限自我重复的时刻。

通过创新的多阶段强化学习技术,他们实现了:

- 循环发生率从15.74%→0.36%的锐减

- 响应延迟降低超90% 潜在影响巨大——设想护士平板或银行家手机可离线完成可靠的医疗诊断或财务分析。

对您的实际意义

等待云端服务器处理复杂请求的时代可能即将终结:

- 旅行者无需WiFi即可获得实时行程调整

- 学生可离线解决高等数学问题

- 野外研究者能随处分析数据 这一切都得益于小到能与自拍和歌单共存的AI大脑。 未来不仅智能——更是便携的。