腾讯全新OCR模型以精简架构打破纪录

腾讯小巧却强悍的OCR模型引发关注

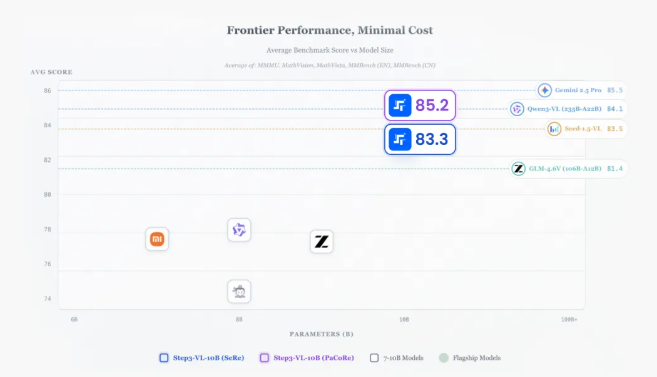

在AI行业普遍追求规模效应的背景下,腾讯混元团队另辟蹊径。其最新开源的OCR(光学字符识别)模型仅用10亿参数就实现了尖端性能——以当今AI标准来看堪称精巧。

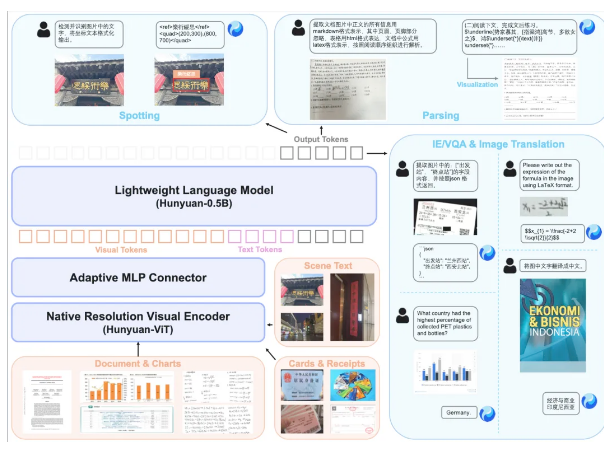

技术文档指出:"混元OCR的特殊之处不在于体积,而在于架构优化程度"。该模型融合三大智能组件:保持原始画质的视频编码器、自适应视觉处理器,以及腾讯高效语言模型。

令人惊讶的性能表现

测试数据令人印象深刻:在OmniDocBench高难度文档解析测试中,混元OCR以94.1分小幅领先体积更大的谷歌Gemini3-Pro。它在九种现实场景中表现优异,包括:

- 手写笔记转录

- 街景标识识别

- 复杂文档分析

最惊人的是,该模型在OCRBench小型模型类别(<30亿参数)中以860分独占鳌头——准确度堪比三倍于自身体积的模型。

不止于文字识别

该模型功能不仅限于字符辨认,还能:

- 直接从票据表格提取数据生成JSON格式

- 自动抓取视频双语字幕

- 支持中英等14种小语种互译

这项多语言能力使其近期斩获ICDAR2025文档翻译竞赛冠军。

现有应用场景一览

尽管技术听起来颇具未来感,它已在处理实际工作:

- 政府证件信息处理

- 辅助视频创作者自动生成字幕

- 促进跨境商务沟通

开发团队特别强调易用性:"与需要多重处理步骤的复杂系统不同",一位开发者指出,"这个模型单次运行就能输出整洁结果"。

目前可通过GitHub和Hugging Face获取该模型,网页浏览器即可直接试用演示版。

核心亮点:

- 小巧精悍:仅10亿参数却超越大型竞品

- 实战利器:擅长文档、手写体、街景标识等多种场景

- 多语专家:支持中英在内16种语言互译

- 轻松集成:简化架构意味着更快部署