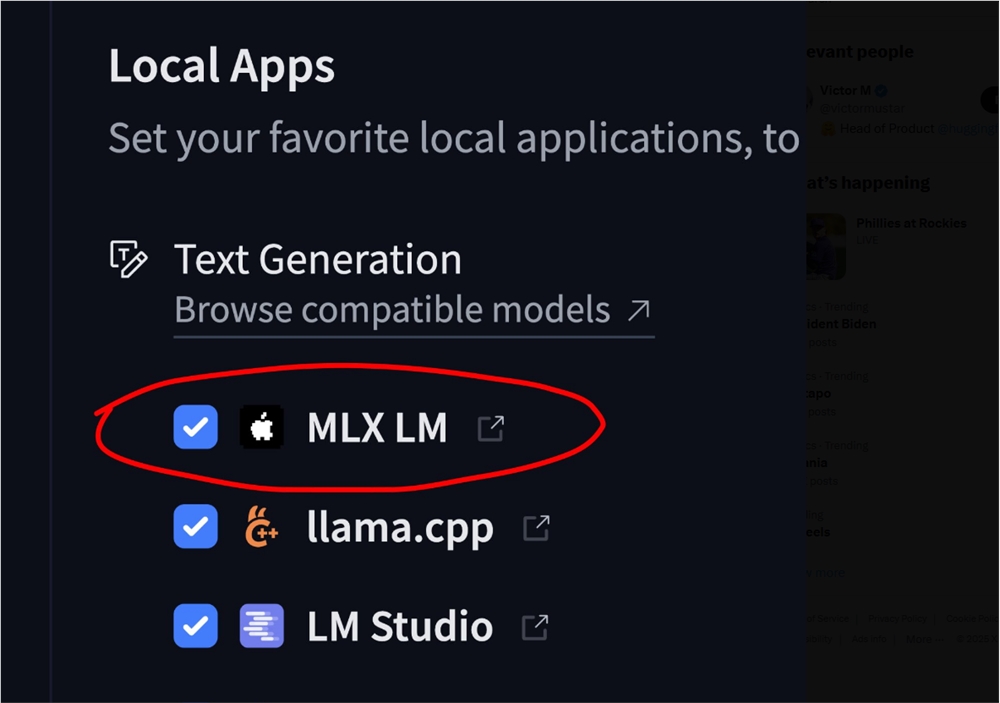

MLX-LM加入Hugging Face,为Apple Silicon AI注入强劲动力

在苹果设备AI开发的重大进展中,MLX-LM框架已全面集成至Hugging Face平台。这一突破使得使用M1至M4芯片的开发者能够以峰值性能本地运行超过4,400个大语言模型——既摆脱了云端依赖,也省去了繁琐的转换流程。

此次整合标志着本地化AI开发的飞跃,为研究者和工程师提供了前所未有的效率。MLX作为苹果专用机器学习框架,经过精心调优以充分发挥Apple Silicon神经引擎和Metal GPU的潜力。而作为其专属LLM组件,MLX-LM将这种优化性能直接带入语言模型工作流。

简化的模型获取 复杂的转换步骤已成为过去。与Hugging Face的整合意味着用户现在可以直接从平台庞大的资源库中获取模型——无需任何中间步骤。这种 streamlined(流线型)方法在保持最佳性能的同时,大幅缩短了设置时间。

为何重要 对于Mac开发者而言,此次更新消除了两大痛点:带来延迟和隐私隐患的云端依赖,以及模型转换的技术障碍。直接兼容性意味着团队能够以空前速度进行原型设计和部署。

该框架对苹果硬件架构的优化承诺了相较于通用解决方案的显著速度优势。早期基准测试显示,在自然语言处理任务常用的基于transformer的模型中表现尤为突出。

可用模型浏览地址:Hugging Face MLX库

核心要点

- 直接Hugging Face集成消除了模型转换需求

- 超过4,400个LLM现可原生运行于M系列芯片

- 充分发挥Apple Silicon神经引擎能力

- 为本地AI开发带来显著性能提升

- 通过减少云端依赖增强隐私保护