Ling-flash-2.0以创纪录的推理速度正式发布

Silicon-Based Flow发布具有突破性性能的Ling-flash-2.0

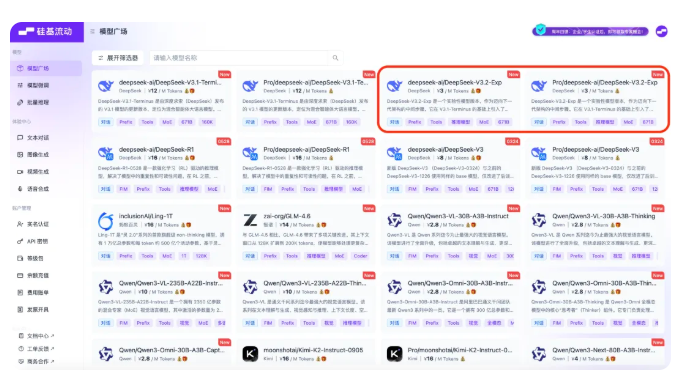

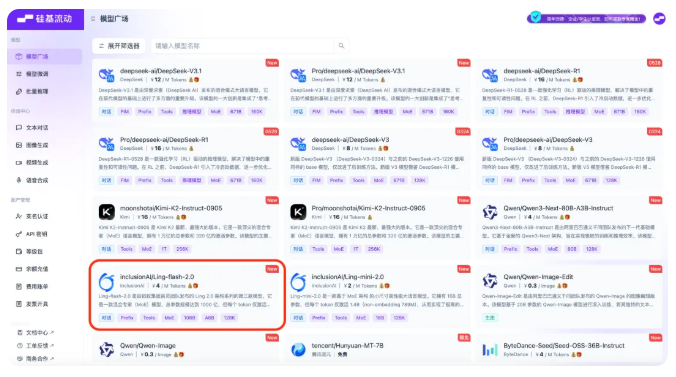

Silicon-Based Flow的大型模型服务平台正式推出Ling-flash-2.0,这是蚂蚁集团百灵团队的最新开源模型。这标志着该平台已提供第130个模型,为开发者带来自然语言处理领域的空前能力。

模型架构与训练

MoE(专家混合)架构驱动着Ling-flash-2.0,其特点包括:

- 总计100亿参数

- 使用时仅激活6.1亿参数(其中4.8亿为非嵌入参数)

- 基于超过20TB高质量数据训练

通过包括预训练、监督微调和强化学习在内的多阶段训练,该模型的性能可媲美激活参数超过60亿的密集模型。

性能与应用场景

Ling-flash-2.0在以下方面表现卓越:

- 复杂推理任务

- 代码生成

- 前端开发

该模型支持惊人的128K上下文长度,显著提升了文本处理能力。定价保持竞争力:

- 输入费用为每百万token 1元人民币

- 输出费用为每百万token 4元人民币

新用户可获得欢迎额度:

- 国内站点赠送14元人民币

- 国际平台赠送1美元

速度与效率优势

经过精心优化的架构带来:

- 在H20硬件上输出速度超过每秒200个token

- 比同类360亿参数的密集模型快三倍 这一突破将密集架构的性能优势与MoE的效率完美结合。

Silicon Flow平台持续扩展其在语言、图像、音频和视频模型的布局,使开发者能够: a) 比较多种模型 b) 组合不同AI能力 c) 访问高效API用于生成式AI应用

开发者可通过以下链接体验Ling-flash-2.0: 中国区:https://cloud.siliconflow.cn/models 国际版:https://cloud.siliconflow.com/models