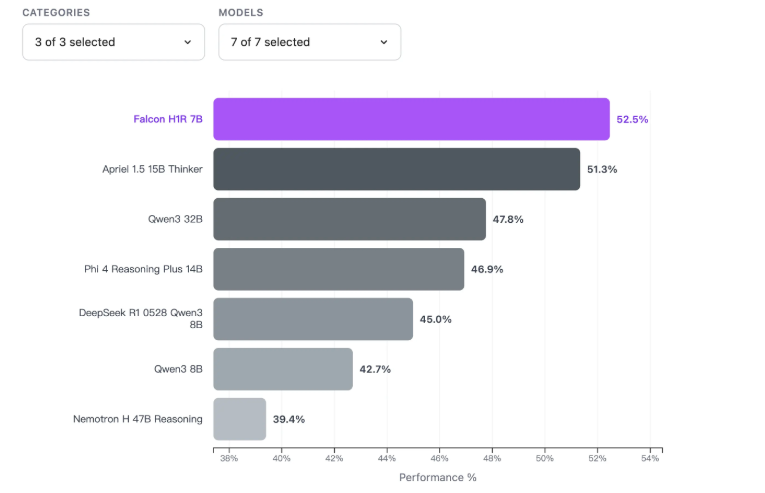

Falcon H1R7B:小巧AI模型性能超越大型竞争对手

Falcon H1R7B证明AI领域大小并非一切

阿布扎比创新研究院(TII)最新发布的Falcon H1R7B引起了广泛关注。这款紧凑的开源语言模型仅包含70亿参数,但其推理能力却让许多更大的模型望尘莫及。

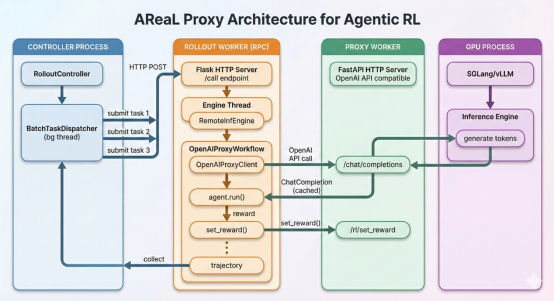

强大性能背后的智能训练

TII的工程师采用了双管齐下的训练方法:

第一阶段: 在他们现有的Falcon-H1-7B基础上,通过"冷启动监督微调"(SFT)集中训练数学、编程和科学推理能力。

第二阶段: 随后实施"强化学习增强"(GRPO),利用奖励机制提升模型的逻辑推理能力并多样化其输出。

"我们看到较小的模型实现了以往需要大量参数才能达到的效果,"项目首席研究员Sarah Khalil博士解释道,"关键在于更智能的训练方法,而不仅仅是更大的模型规模。"

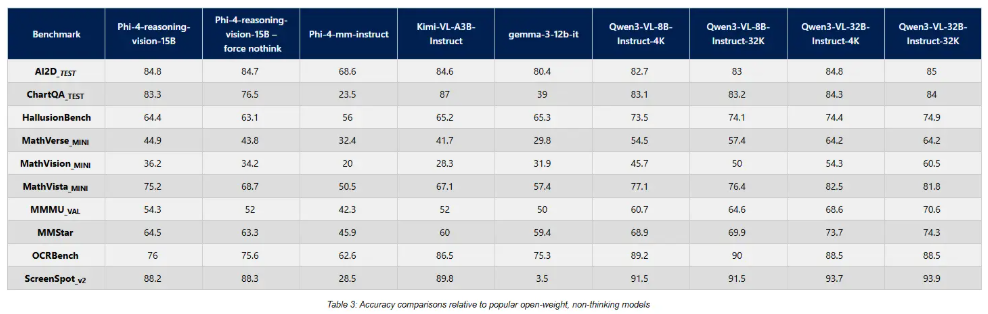

令人惊讶的性能表现

数据讲述了一个令人印象深刻的故事:

- 88.1% 在AIME-24数学测试中的得分(超越许多150亿参数的模型)

- 68.6% 在LCB v6编码挑战中的表现(在80亿参数以下模型中名列前茅)

- 在MMLU-Pro和GPQA通用推理测试中取得有竞争力的分数

秘诀何在?他们的"深度思考与自信"(DeepConf)方法在提高准确性的同时减少了token生成数量——就像专家能直达要点而不必赘述一样。

为实际应用而生

Falcon H1R7B真正与众不同之处在于其实用效率:

- 每GPU处理速度高达1500 tokens/秒——几乎是某些竞争对手的两倍

- 即使在较低性能硬件上也能保持强劲表现

- 采用混合Transformer/Mamba架构以更好地处理长上下文场景

该模型的完整版和量化版已可在Hugging Face上获取,降低了开发者和研究人员的使用门槛。

关键要点:

- 小巧而强大: 70亿参数胜过许多更大的模型

- 专业化训练: 两阶段方法最大化推理能力

- 实战就绪: 高吞吐量适应各种硬件配置

- 开放获取: 现已可供社区使用和开发