苹果STARFlow-V采用颠覆性方法实现稳定视频生成

苹果押注归一化流技术打造下一代视频AI

与行业趋势截然不同,苹果推出了完全绕过主流扩散技术的视频生成模型STARFlow-V。该模型采用归一化流——一种将随机噪声直接转化为连贯视频帧的数学方法。

归一化流为何重要

当Sora或Runway等扩散模型通过多次噪声迭代逐步优化视频时,STARFlow-V选择了更直接的路径。想象通过展示完整杰作而非反复擦除重画来教人绘画——这就是该技术的本质区别。

其优势显而易见:

- 训练一次完成,无需无数微调

- 生成几乎瞬时完成

- 减少迭代处理导致的错误累积

苹果宣称STARFlow-V在质量上媲美扩散模型,且生成5秒片段的速度比初期原型快约15倍。

破解长视频难题

真正的突破在于处理长序列。大多数AI视频工具在超过几秒后就会因逐帧错误累积而失效。STARFlow-V通过创新双架构解决这一问题:

- 一个系统维持跨帧运动一致性

- 另一个优化单帧细节表现

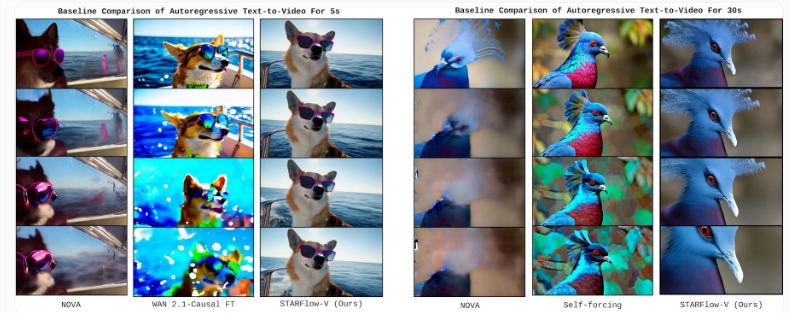

结果如何?稳定的30秒演示中,竞品模型几秒内就会出现模糊或失真。

能力与局限

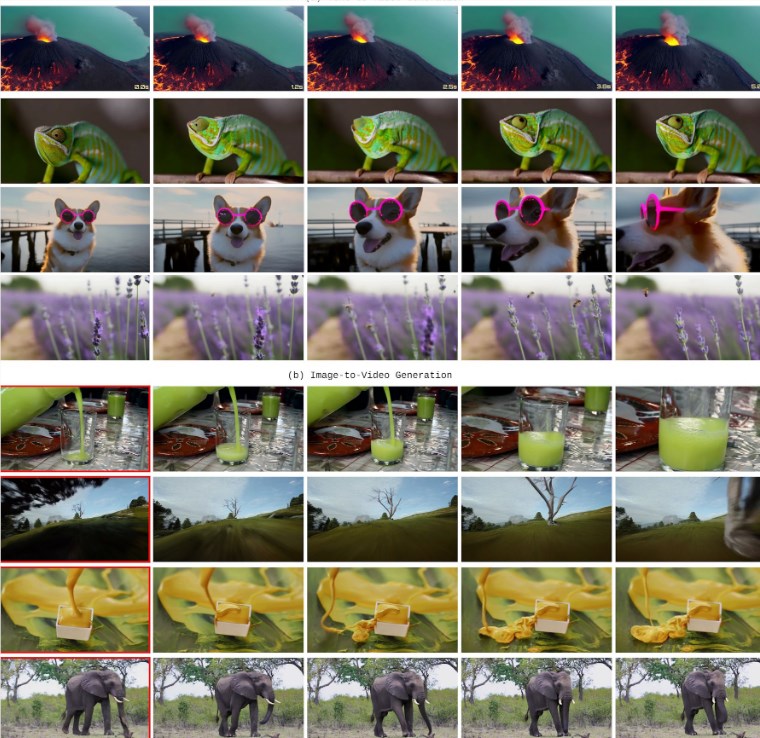

该模型开箱即支持多种任务:

- 根据文本提示生成视频

- 为静态图像添加动画效果

- 通过添加或移除对象编辑现有素材

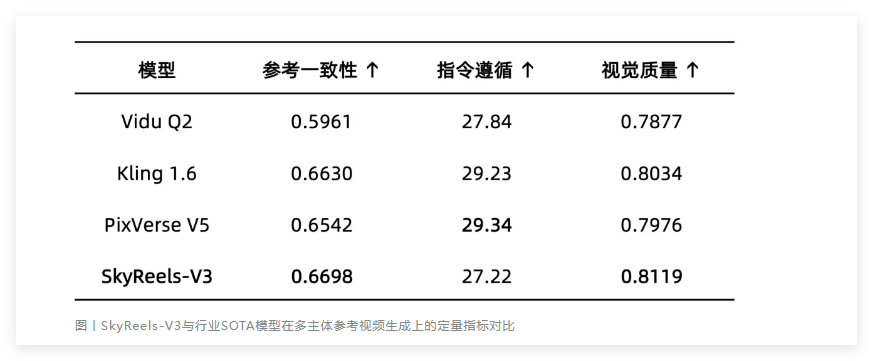

基准测试显示STARFlow-V在VBench获得79.7分——虽逊于Veo3(85.06)等领先者,但在空间关系和人体形象的真实渲染方面显著优于其他自回归模型。

当前版本仍有不足:

- 最高分辨率仅640×480像素

- 标准GPU尚无法实时处理

- 物理模拟偶现异常(如章鱼穿透玻璃)

苹果承认这些局限,计划重点优化速度、压缩模型并引入更精确的物理训练数据。公司已在GitHub发布代码,模型权重即将登陆Hugging Face。

核心要点:

- 苹果STARFlow-V采用归一化流而非扩散模型

- 实现竞品难以企及的30秒稳定视频

- 直接处理帧而非迭代优化

- 目前基准分数略逊顶尖模型

- GitHub已开源代码,Hugging Face即将发布权重