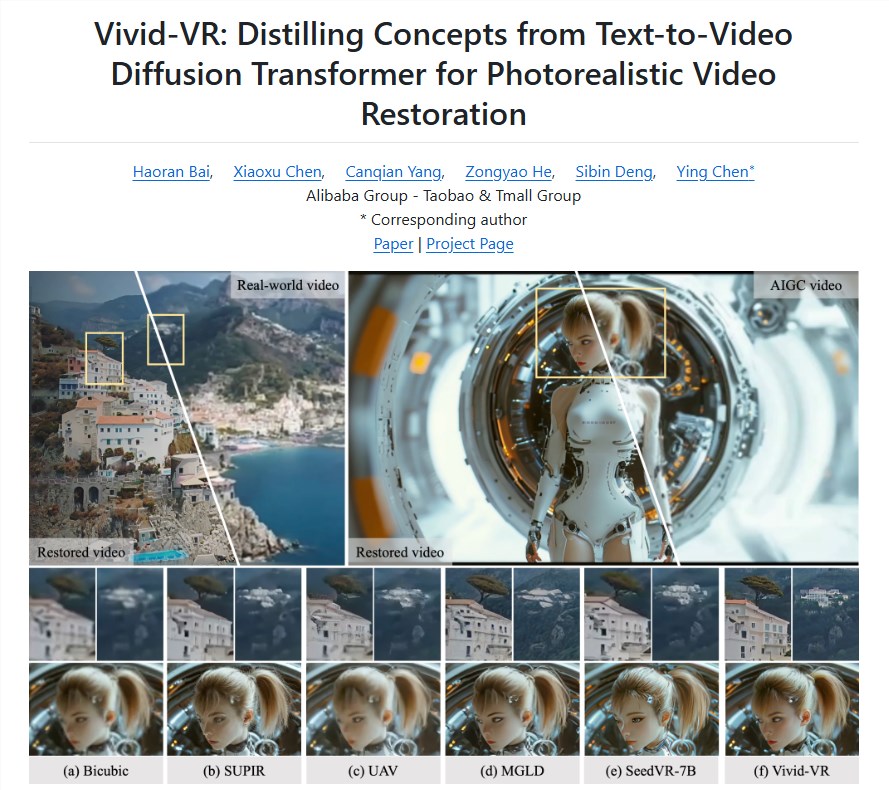

阿里巴巴Vivid-VR:AI视频修复技术正式开源

阿里云开源尖端视频修复工具

阿里云已将其Vivid-VR生成式视频修复工具作为开源软件公开发布。这一技术突破利用先进的文本到视频(T2V)模型与ControlNet技术相结合,在修复的视频内容中实现了前所未有的帧一致性。

Vivid-VR背后的技术创新

该系统架构代表了视频处理领域的重大飞跃:

- T2V基础模型:通过深度学习算法生成高质量视频内容

- ControlNet集成:保持帧间时间一致性,消除常见伪影

- 动态语义调整:在生成过程中增强纹理真实感

"Vivid-VR的独特之处在于它能在显著提高修复效率的同时保持视觉稳定性,"开发团队解释道。早期测试显示,该工具能同等有效地处理传统拍摄素材和AI生成内容。

广泛的行业应用

该工具特别适用于:

- 内容创作者修复低质量源素材

- 后期制作团队优化AI生成的视频

- 档案项目修复历史影像资料

- 社交媒体平台增强用户生成内容

支持多种输入格式的Vivid-VR允许针对特定用例进行参数定制,使其能够适应各种创意和技术工作流程。

开源可访问性

阿里云已通过多个平台发布Vivid-VR:

- GitHub(主要代码仓库)

- Hugging Face(模型共享)

- ModelScope(阿里巴巴的模型中心)

此举延续了该公司下载量超过220万的Wan2.1系列的成功。开源方式显著降低了全球开发者的使用门槛。

行业影响分析

2025年的数字景观日益依赖视频内容,但质量问题依然存在:

- 78%的创作者表示受困于素材质量不一致(AIbase 2025年调查)

- AIGC平台因生成伪影导致42%的用户流失

Vivid-VR解决了这些痛点,同时可能在以下领域创造新的收入来源:

- 自动化视频增强服务

- 传统媒体修复业务

- 实时处理应用场景

该工具的发布恰逢对AI辅助创意工具需求不断增长之际,据Gartner预测,到2027年这一市场将达270亿美元规模。

关键要点:

- 帧一致性:先进的ControlNet集成消除了闪烁和抖动伪影

- 双重兼容性:能有效处理传统视频和AIGC内容

- 开放生态系统:通过主要开发者平台完全开放模型和代码访问

- 定制选项:可调整参数以适应专业用例

- 行业变革:有望重新定义多个领域的视频质量标准