AI模型在简单日历问题上栽跟头

当智能AI算错基础数学题

能写诗编程的人工智能系统,却在一个三年级学生都能回答的问题上栽了跟头:当前年份的下一年是哪年?

日历难题事件

当用户发现询问"2027年是明年吗?"会触发多个顶级AI系统的怪异回答时,问题浮出水面。Google AI概览给出了最令人费解的回答:"当前是2026年,所以明年应该是2028年",直接跳过了2027年。

特别令人惊讶的是,这些模型并非被要求解决复杂方程或解释模糊陈述——仅仅是进行简单的日历运算。

行业领军者措手不及

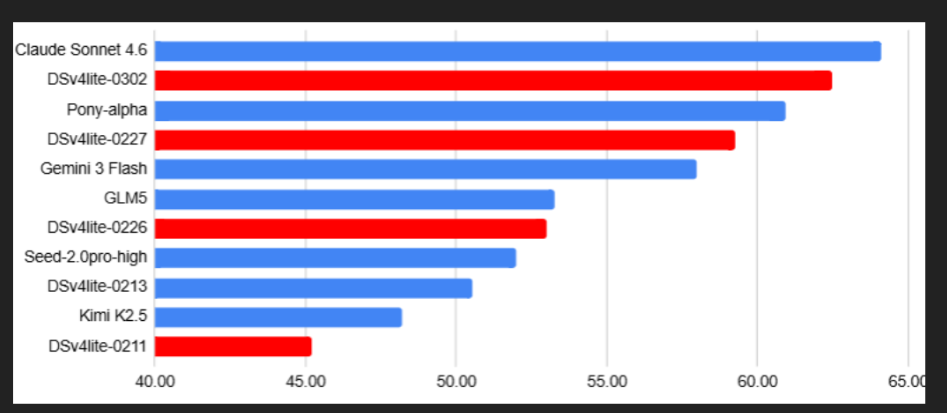

受此故障影响的主要厂商包括:

- Google AI概览 自信地提供错误信息并附带虚构引用

- ChatGPT(5.2版本) 最初否认2027年是明年,随后自我纠正

- Claude 3.5 表现出类似犹豫后得出正确答案

唯一立即答对的是Google较新的Gemini 3模型。

事件意义

这不仅是日期错误的问题。该事件揭示了当前AI系统的两大关键弱点:

- 时序推理:许多模型难以理解超越简单模式识别的时间序列和进程

- 过度自信:系统经常以不必要的确定性提供错误答案,而非承认不确定性

"就像看到数学教授忘记加法运算",一位在社交媒体平台最早关注此发现的观察者评论道。

深层启示

虽然表面看来有趣,但这一事件重要提醒着我们:即使先进AI系统也存在局限。随着我们日益依赖这些工具获取信息,此类事件凸显保持健康怀疑态度的必要性。

一线希望?这类公开失误帮助开发者发现并修复弱点——使未来版本更可靠。

关键要点:

- 📅 多个顶级AI模型未通过关于当前年份下一年的基础日历逻辑测试

- 🤯 部分回应包含关于连续年份的自相矛盾说法

- 🔍 这些错误揭示大语言模型在时序推理方面持续存在的挑战

- ✅ 唯有Google Gemini 3未经提示即给出正确答案

- ⚠️ 事件凸显验证AI生成信息的重要性