mmBERT在多语言NLP效率上超越XLM-R

多语言NLP突破:mmBERT树立新标杆

约翰霍普金斯大学的研究团队推出了革命性的多语言编码器mmBERT,在速度和准确性上均超越了XLM-R等现有模型。这一进展弥补了多语言自然语言处理(NLP)的关键空白,为全球语言应用提供了更强支持。

架构创新

mmBERT框架包含两大主要配置:

- 基础模型:22层Transformer,1152维隐藏层(约3.07亿参数)

- 小型模型:优化后约1.4亿参数

关键技术革新包括:

- 支持256k词汇的Gemma2分词器

- 旋转位置编码(RoPE)

- FlashAttention2技术

- 序列长度从1024扩展到8192个token

全面训练策略

该模型在空前规模的数据集上训练完成:

- 覆盖1833种语言的3万亿token

- 英语仅占语料库的10%-34%

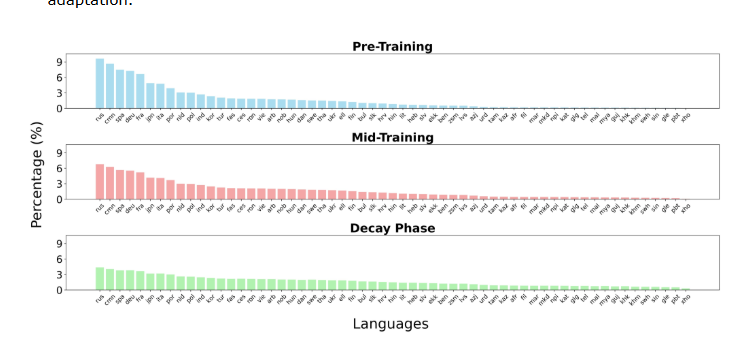

- 三阶段训练策略:

- 预训练基础阶段

- 中期训练优化阶段

- 衰减阶段调优

分阶段方法确保逐步接触多样语言,特别有利于低资源语言表现。

基准测试领先优势

mmBERT在多项评估中展现卓越性能:

| 测试基准 | mmBERT得分 | XLM-R得分 |

|---|

该模型还在以下领域表现突出:

- 嵌入任务

- 代码检索应用

- 低资源语言处理(法罗语、提格里尼亚语)

未来影响

这一突破重新定义了以下领域的可能性:

- 全球通信系统

- 跨语言AI应用

- 语言多样性保护 mmBERT由此成为下一代多语言NLP系统的基石。

开源模型地址:GitHub仓库

关键亮点:

✅ 性能领跑者:多项基准测试超越XLM-R ⏱️ 速度优势:数据处理速度比前代快2-4倍 🌐 语言包容性:专项训练增强低资源语言能力