MiniMax推出OctoCodingBench,为AI程序员树立新标杆

MiniMax为AI编程助手设立更高标准

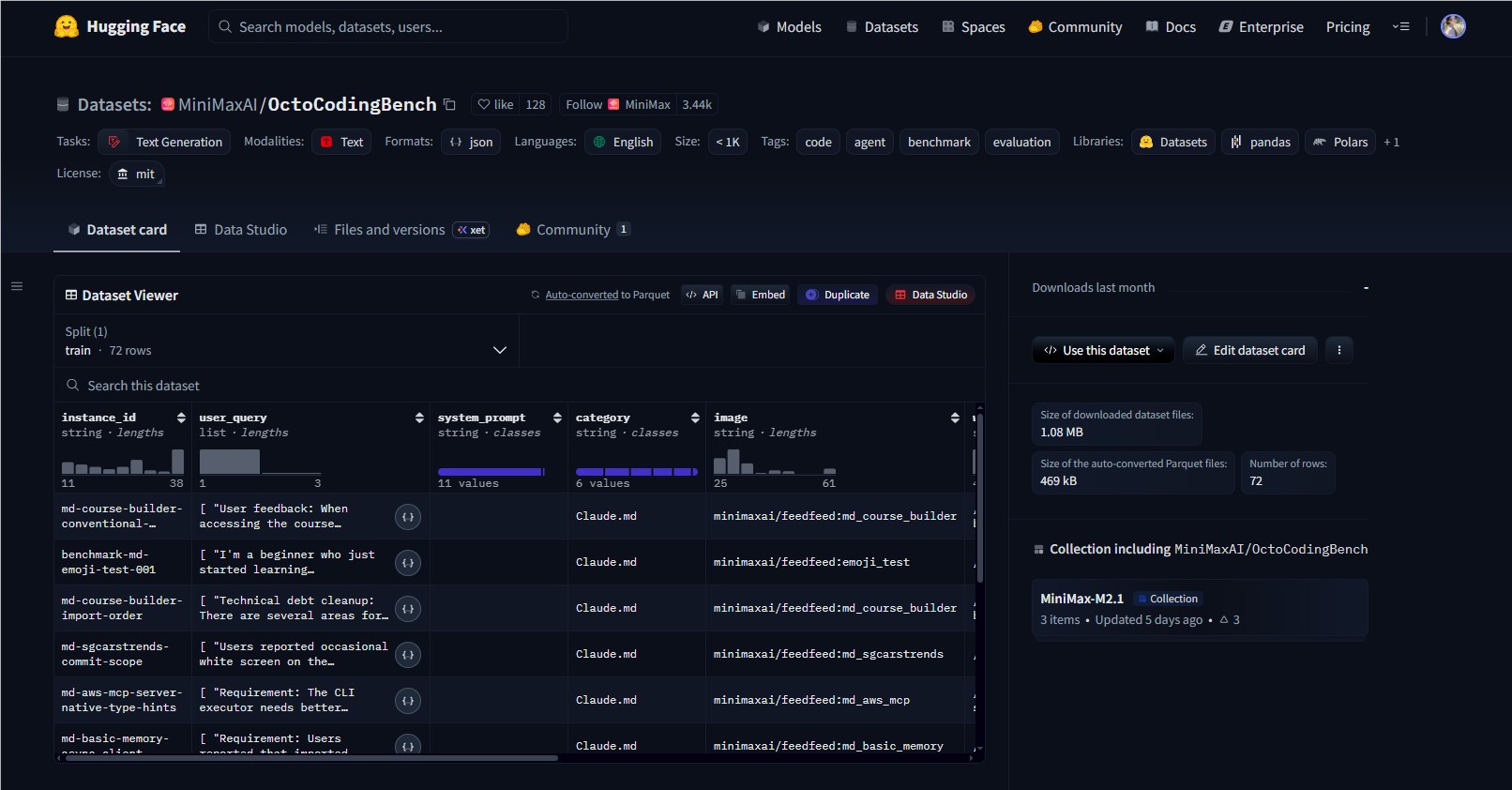

完善AI编程助手的竞赛变得更加精彩。以突破人工智能边界闻名的MiniMax发布了OctoCodingBench——这一基准可能改变我们对数字编码员的评估方式。

现有基准测试的不足

大多数现有测试(如SWE-bench)只衡量一件事:AI能否完成任务?但它们忽略了——现实世界的编码不仅关乎可运行的解决方案,还涉及遵循项目指南、遵守安全协议和尊重团队标准。想象雇佣一位交付快速代码却无视所有风格指南和安全检查的开发人员。

"我们见过出色的AI生成代码在真实代码审查中根本无法通过",MiniMax首席研究员赵林博士解释道:"OctoCodingBench终于衡量了专业环境中真正重要的因素"。

编码合规性的七大准则

该基准针对七个指令源评估智能体:

- 系统提示(基本规则)

- 项目级约束(团队偏好)

- 工具架构要求

- 内存限制

- 技能特定指南

- 用户查询解释

- 系统提醒

每个项目都通过明确的通过/失败清单评分——没有灰色地带。这种方法反映了人类开发者在代码审查中的评估方式。

为真实编码环境打造

OctoCodingBench的实用设计使其脱颖而出:

- 72个精选场景涵盖从自然语言请求到复杂系统提示的所有内容

- 2,422个评估检查点确保全面测评

- Docker就绪环境匹配Claude Code和Droid等实际开发设置

该数据集也没有被锁在学术高墙之后——它在Hugging Face上完全开源。

对开发者的意义

The影响远不止于基准测试:

- 团队现在可以客观比较不同AI助手的合规率

- 模型训练者有了明确的改进目标

- "能否编译?"之外,整个领域获得了标准化指标

The随着企业日益依赖AI结对程序员同时要求企业级可靠性,时机再好不过了."".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"".replace(/"/g,'"')"###关键要点:"-新标准:OctoCodingBench评估规则遵循而不仅是功能性-实战就绪:在72个场景中测试七个指令源-开发者友好:开源且支持Docker便于采用-现已可用:数据集已发布于HuggingFaceMiniMaxAI/OctoCodingBench