Liquid AI的小型动力源为小型设备带来强大AI

Liquid AI的紧凑型AI模型掀起巨浪

在一个在人工智能领域‘越大越好’的时代,Liquid AI正采取一种不同的方法。他们新发布的LFM2.5家族证明了好东西确实可以以小包装呈现——尤其是在边缘计算方面。

小模型,大抱负

LFM2.5系列基于公司现有的LFM2架构,但在内部带来了重大升级。是什么让这些模型与众不同?它们是专门设计来在日常设备上高效运行的,而不是需要庞大的云服务器。

"我们看到对能够在本地运行的有能力AI的巨大需求," Liquid AI的首席研究员Sarah Chen博士解释道。"无论是隐私问题还是对实时响应性的需求,都有充分的理由将智能直接带到设备上。"

技术突破

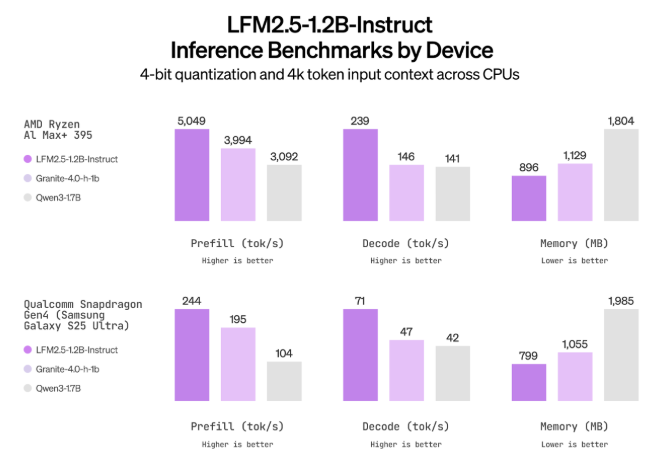

数字讲述了一个令人印象深刻的故事:

- 训练数据从10万亿标记增加到28万亿标记,几乎翻了三倍

- 参数扩展到1.2亿

- 包括针对日语、视觉语言和音频语言任务的专门变体

这些模型通过监督学习和多阶段强化训练进行了严格的微调。这种专注的方法帮助它们在特定挑战(如数学推理和工具使用)上表现出色。

基准测试主导地位

当进行测试时:

- 通用型LFM2.5-1.2B-Instruct在GPQA上得分38.89,在MMLU Pro测试中得分44.35

- 以显著优势超越可比模型如Llama-3.2-1B Instruct

- 日语专用版本在本地语言任务中表现出特别的优势

视觉语言模型(LFM2.5-VL-1.6B)带来了图像理解能力,非常适合文档分析和界面阅读——想象更智能的扫描应用或无障碍工具。

与此同时,音频模型(LFM2.5-Audio-1.5B)处理语音的速度比之前的解决方案快八倍,为不依赖云的实时语音应用打开了大门。

为什么这很重要

科技行业正在意识到仅依赖云的AI解决方案的限制: 1️⃣ 隐私:保持敏感数据本地化 2️⃣ 可靠性:在没有互联网连接的情况下运行 3️⃣ 响应性:消除网络延迟 4️⃣ 成本:减少昂贵的云计算需求

随着这些开源模型现在可在Hugging Face上获取并在Liquid的LEAP平台上展示,全球开发者今天就可以开始尝试强大的边缘AI解决方案。

关键点:

- 紧凑的动力源:LFM2.5系列在为边缘设备优化的紧凑包装中提供了令人印象深刻的性能。

- 多模态掌握:从文本处理到图像和音频理解——全部能在本地高效运行。

- 开放访问:作为开源权重提供,鼓励广泛采用和创新。