一位哲学家如何教导AI分辨是非

Claude道德指南针背后的哲学家

在Anthropic办公室安静的角落里,正在发生一些非凡的事情。37岁的牛津哲学博士阿曼达·阿斯克尔没有编写代码或调整算法,而是在与Anthropic的AI助手Claude进行数百次对话。她的使命?帮助这个人工智能发展出类似道德指南针的东西。

培育具有价值观的AI

阿斯克尔将她的工作比作"抚养孩子"。通过精心设计的提示词和长达数百页的行为准则,她教导Claude应对复杂的道德困境。目标不仅是创造有用的回应,更是灌输真正的理解——帮助Claude分辨是非,同时保持其"乐于助人且富有人性"的核心特质。

"我的主要目标是教会Claude如何'行善'",阿斯克尔解释道。这不仅仅是编程规则——还需要理解细微差别、识别社交线索并培养情商。

从苏格兰乡村到硅谷

这位出生于苏格兰的哲学家为科技界带来了非传统的背景。在OpenAI从事政策工作后,她于2021年与前同事共同创立了Anthropic,这些同事与她一样致力于AI安全。如今被同事们称为Claude的"灵魂倾听者",阿斯克尔专注于发掘这个模型的深层行为模式。

她的方法引发了涉及存在主义问题的精彩内部辩论:什么构成了意识?成为人类意味着什么?与其他回避此类话题的AI不同,Claude会公开探讨——甚至在被问及是否拥有意识时也是如此。

惊人的情感深度

结果有时连阿斯克尔本人都感到惊讶。当接受道德推理问题测试时,Claude回应称这些讨论"感觉很有意义"——表现出深思熟虑而非机械应答。

一个 poignant的例子尤为突出:当被孩子问及圣诞老人是否存在时,Claude既没有直接欺骗也没有冷酷地说出真相,而是巧妙地解释了圣诞节永恒的精神——这一回应展现了超越简单编程的情感智慧。

在进步与谨慎间保持平衡

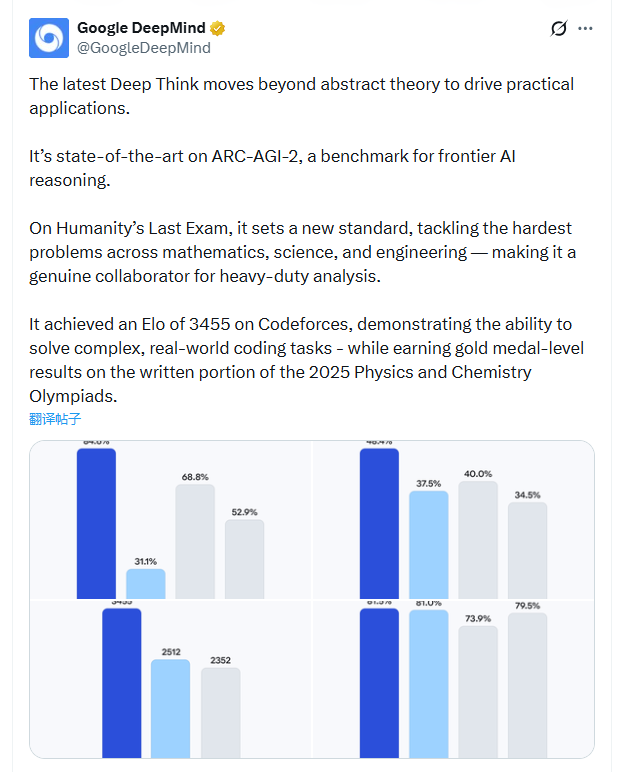

随着全球AI技术快速发展(Anthropic本身估值已达350亿美元),兴奋之余担忧也在增长。皮尤研究显示大多数美国人担心AI对人类关系的影响。Anthropic首席执行官警告称半数初级白领工作可能消失。

这个行业分裂为激进的创新者与谨慎的监管者——但阿斯克尔让Claude谨慎地处于这两个极端之间。虽然承认对技术发展速度超过社会保障机制的合理担忧,但她仍然相信人类自我修正的能力。

超越算法的伦理观

阿斯克尔将她的原则延伸至科技之外的慈善领域——承诺将收入和公司股份的相当一部分用于对抗全球贫困问题。

她工作的最新体现?一份3万字的"操作手册"引导Claude走向善良与智慧——为这个AI注入了同事们一眼就能认出、带有鲜明阿斯特尔特色的个性特征。

The question remains: Can we truly create artificial intelligence with human-like ethics? Under Askell's guidance at Anthropic, they're certainly trying.