谷歌Gemini遭围攻:黑客通过持续提问窃取AI机密

谷歌应对针对Gemini AI的大规模攻击

在被安全专家称为对人工智能系统史无前例的袭击中,谷歌本周披露其Gemini聊天机器人遭受了旨在提取核心算法的持续提问攻击。攻击者向系统发送精心设计的提示——有时单次攻击就超过10万次查询——试图逆向工程分析AI的思考方式。

AI窃密手法解析

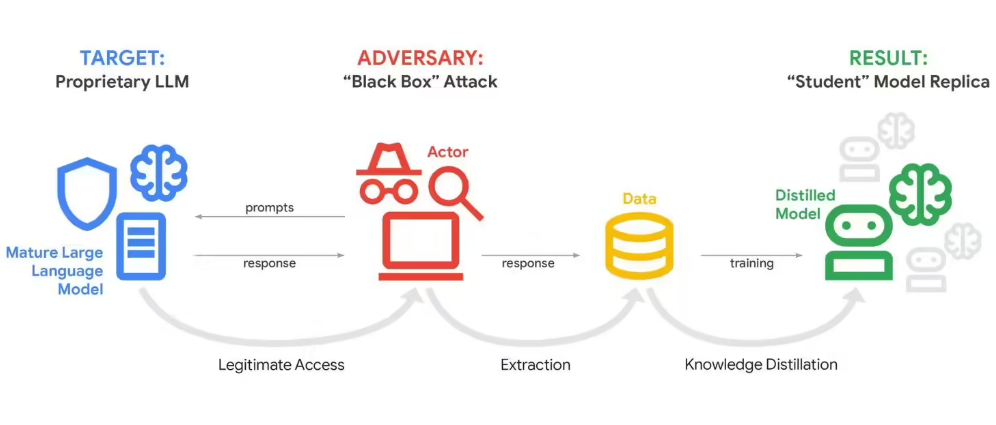

这种被称为"模型蒸馏"的技术,其原理类似于通过反复访谈来理解某人的决策过程。通过分析Gemini对数千个相似问题变体的响应模式,攻击者可以拼凑出驱动AI的底层逻辑。

"这不仅仅是好奇心——而是商业间谍行为,"谷歌首席威胁分析师John Hottelquist表示,"我们看到资金充足的组织在系统性探测我们的系统,试图窃取价值数十亿美元的研究成果。"

谁是幕后黑手?

虽然谷歌没有点名具体责任方,但有证据指向希望在人工智能竞赛中走捷径的竞争AI公司和研究机构。攻击源自全球多个地点,表明这是协调行动而非孤立事件。

利害关系极为重大。像Gemini这样的大型语言模型代表着科技公司最有价值的资产——是计算能力和人类专业知识巨额投入的产物。它们的内部机制构成了堪比可口可乐秘方的商业机密。

给所有企业的警钟

Hottelquist将谷歌的经历描述为AI安全领域的"煤矿中的金丝雀"。随着更多企业开发包含专有数据和流程的定制AI工具,它们都可能成为类似提取尝试的目标。

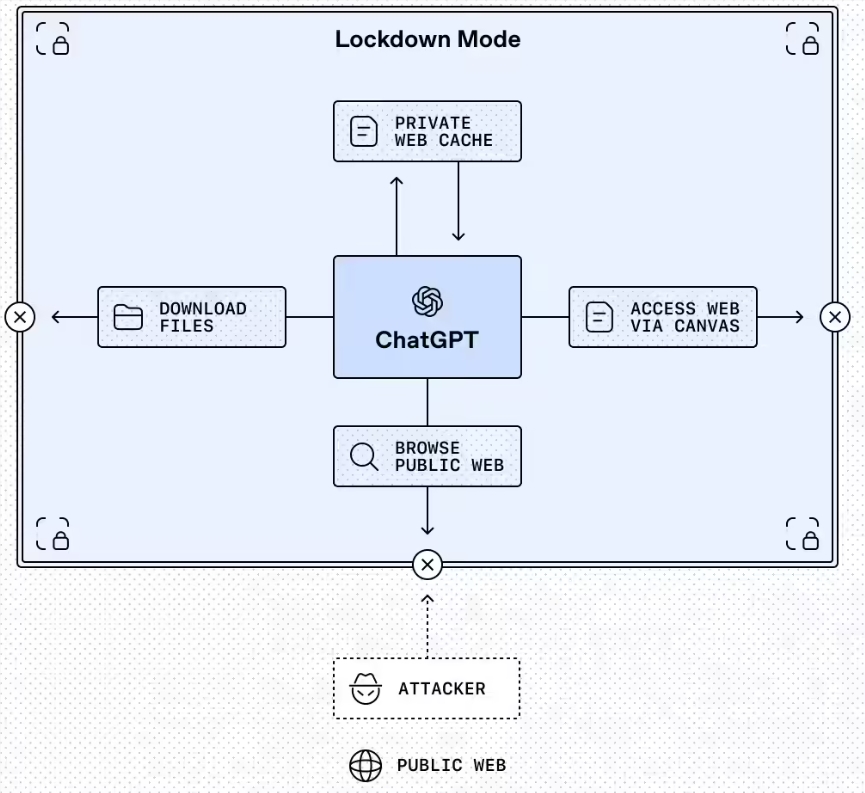

这些攻击暴露了当今AI领域的一个根本矛盾:这些强大工具需要广泛可访问性才能发挥作用,但同样的开放性也使它们变得脆弱。现有的防护措施可以检测和阻止许多提取尝试,但愿意投入时间和资源的坚定攻击者往往能找到规避方法。

未来影响展望

这一事件引发了关于如何在AI领域平衡创新与保护的难题:

- 企业如何在保持产品可访问性的同时保护投资?

- 是否应该对模型蒸馏尝试追究法律责任?

- 这会加速向更封闭的AI系统转变吗?

有一点似乎可以确定:随着人工智能在全球商业运营中变得越来越核心,保护这些系统只会变得更加关键——也更具挑战性。

关键要点:

- 规模:针对Gemini核心逻辑的攻击涉及超过10万条提示

- 动机:商业竞争对手寻求专有AI算法

- 风险:可能窃取多年研发投资成果

- 更广泛影响:标志着所有使用定制AI的企业面临的新兴威胁