AI安全成绩单:科技巨头在关键措施上表现不佳

AI安全受审视:主要参与者未达标准

生命未来研究所(FLI)发布的一份令人警醒的新报告描绘了行业内AI安全标准的严峻现状。其全面的《2025年AI安全指数》评估了包括OpenAI和Google DeepMind在内的二十多家领先公司,结果令人失望。

安全差距

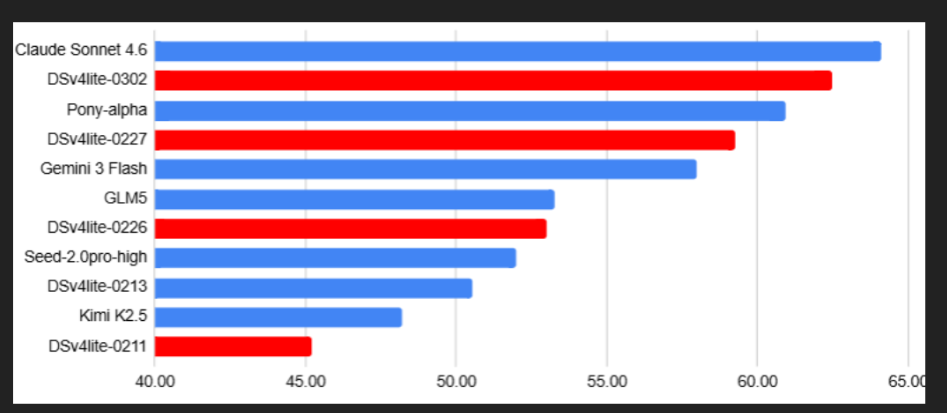

该评估聚焦四个关键领域:风险评估协议、安全框架、存在性风险规划和信息透明度。在这些类别中,公司的平均得分仅为42分(满分100分),远低于欧盟监管机构设定的基准。

"最让我们惊讶的不是任何单一缺陷," FLI的研究主任解释道,"而是公司在多个安全维度上普遍表现不佳的一致性。"

主要缺陷:

- 风险管理: 仅有三家公司披露了系统性的潜在危险识别方法

- 超级智能防护措施: 关于控制先进AI系统的技术细节大多未公开

- 安全基础设施: 大多数公司缺乏专门的安全官员或记录在案的应急协议

- 透明度: 公开披露在深度和可验证性方面比推荐水平低30%

行业反应

该报告引发了科技领袖们的不同反应。OpenAI确认已收到调查结果,并承诺在三个月内更新安全框架。Google DeepMind的回应更为谨慎,仅表示他们正在与政策团队"评估建议"。

欧洲监管机构似乎没那么耐心。欧盟内部市场专员暗示该指数将直接影响即将出台的AI法规的执行,不合规的公司可能面临高达全球收入2%的罚款。

下一步是什么?

FLI建议建立一个"AI安全透明度注册表"以标准化行业内的信息披露。他们还推动对先进AI系统实施强制性的预发布审批——这与当前的"先发布后监管"方式有显著不同。

市场分析师预测这些发展可能会从根本上改变AI的开发方式。一些人估计顶级公司可能很快会将10-15%的研发预算专门用于安全和合规措施。

"这不是要减缓创新,"一位FLI研究员强调道,"而是要确保创新不会超出我们管理其后果的能力范围."

关键点:

- 全行业关键评估中的平均安全得分仅为42/100

- 风险规划和透明度实践存在重大差距

- 监管变化可能带来重大的经济处罚

- 公司可能需要大幅增加安全投入

- 针对先进AI系统提出了新的监督机制