研究警告:过度使用AI可能损害批判性思维

麻省理工研究揭示AI依赖的认知代价

麻省理工学院媒体实验室的新研究警告称,广泛使用ChatGPT等大型语言模型(LLMs)可能带来显著的认知权衡。这项由Nataliya Kosmyna领导的研究探讨了在学术写作任务中,AI辅助如何影响学习过程。

研究方法

研究团队将54名参与者分为三组进行实验:

- LLM组:仅使用ChatGPT进行写作

- 搜索引擎组:使用传统搜索工具(无LLMs)

- 纯脑力组:不使用任何数字工具

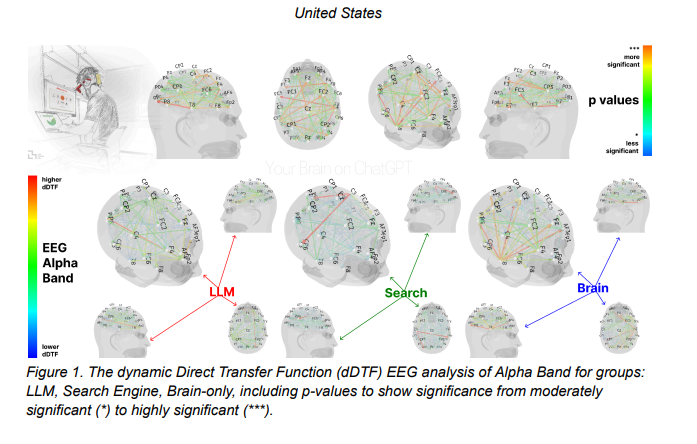

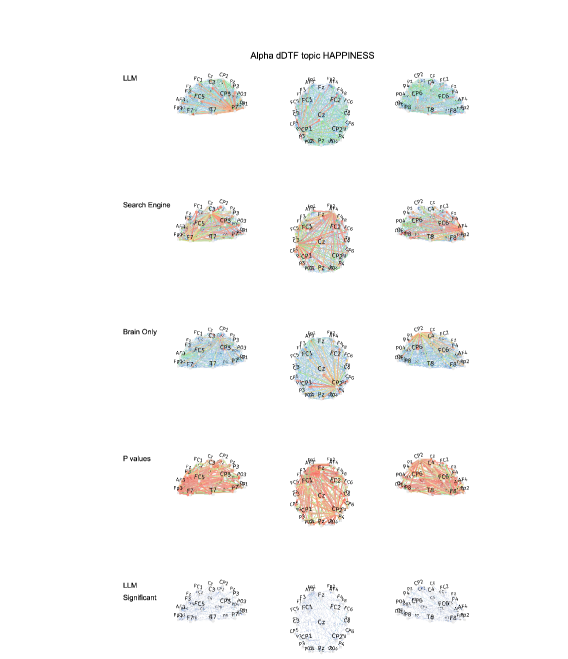

研究人员通过脑电图扫描监测参与者在完成写作任务时的大脑活动。研究包含四个环节,在最后一轮进行角色互换,让部分参与者在工具依赖和无工具方法之间切换。

关键发现:AI使用的神经影响

研究揭示了大脑连接模式的显著差异:

- 最强连接性出现在纯脑力组

- 中等连接性出现在搜索引擎用户中

- 最弱整体耦合存在于LLM用户中

从AI辅助过渡到无辅助工作的参与者表现出特别令人担忧的结果:

- α波活动减少(与创造力和语义处理相关)

- β波模式减弱(与专注力相关)

- 情景记忆巩固受损

"这些发现表明依赖AI可能形成被动学习方法,削弱批判性思维,"Kosmyna解释道。"我们看到所谓的'认知债务'——以长期认知发展为代价换取短期效率提升。"

教育影响与建议

该研究强调了学术环境中的几个问题:

- 记忆编码:LLM用户在回忆自己撰写的内容时表现出困难

- 归属感:AI辅助的写作者对其作品的连接感较弱

- 认知能动性:传统方法能促进对材料的更深层次参与

团队建议采取平衡方法:

- 在引入AI辅助前实施"无工具"学习阶段

- 在建立基础神经网络后有选择地使用AI

- 开发区分人类创作与AI生成内容的方法

研究总结称,虽然LLMs带来了不可否认的生产力优势,但教育工作者必须谨慎考虑其整合方式,以保护批判性思维技能和知识保留能力。

关键点:

- 脑部扫描显示频繁使用AI者连接性较弱

- 依赖LLMs完成写作任务会损害记忆编码

- 重复依赖AI会积累认知债务

- 平衡的教育方法可能减轻负面影响

- 随着AI辅助增加,归属感下降