北京大学新型芯片为AI带来228倍能效提升

北京大学团队用革命性芯片打破AI功耗壁垒

随着人工智能系统日趋复杂,其对计算能力的渴求已变得难以满足——直到现在。由北京大学人工智能学院孙仲研究员带领的团队,开发出一款可能彻底改变高能耗AI应用的模拟计算芯片。

AI领域的功耗难题

现代AI系统(特别是处理图像分析和推荐引擎的系统)在实时处理海量数据时常常遭遇瓶颈。传统数字芯片面临两大根本挑战:计算复杂性和内存限制。"我们意识到需要彻底改变思路,"孙仲解释道,"与其用数字逻辑对抗物理规律,不如顺势而为。"

新芯片的运作原理

该团队的突破在于采用专门为非负矩阵分解(NMF)优化的模拟计算原理——这是许多AI应用背后的核心技术。与按顺序处理二进制代码的数字芯片不同,这种新设计利用物理定律直接进行并行计算。

想象一下:通过逐步书写来解复杂数学题,或是目睹解决方案通过物理交互自然呈现——这就是该方法高效的本质。该芯片消除了传统硬件所需的大部分开销,从根本上降低了延迟和功耗。

令人瞩目的性能表现

数据说明一切:

- 比当前高端数字芯片快12倍的处理速度

- 228倍的能效提升

- 图像压缩任务节省50%存储空间

- 推荐系统训练获得显著性能提升

"这不仅仅是渐进式改进,"一位审阅该研究的行业分析师指出,"我们谈论的是数量级的飞跃,可能重新定义边缘AI设备的可能性边界。"

实际应用影响

这项技术的意义远超实验室基准测试:

- 图像处理在保持高精度的同时节省一半存储空间

- 推荐算法在商业数据集上的训练速度创下新纪录

- 该技术特别适合对速度和能效都有严苛要求的实时应用场景

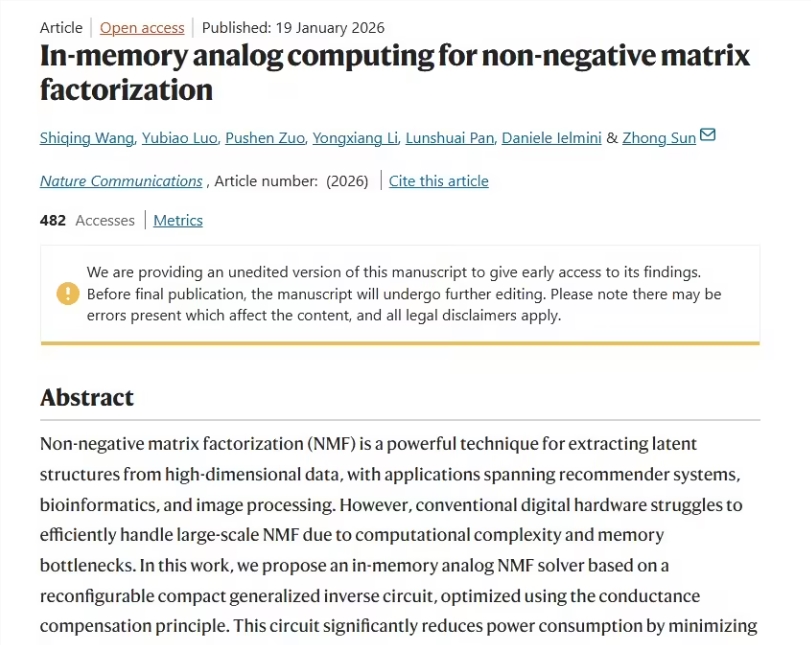

孙仲团队1月19日在《自然·通讯》发表研究成果后,立即引起学术界和产业界的关注。虽然尚未公布商业化计划,但研究人员暗示其潜在应用涵盖智能手机摄影到个性化购物推荐等多个领域。

对AI未来的意义

这项突破来得正是时候。随着AI模型日趋庞大复杂,其环境影响备受关注。这款在提供卓越性能的同时仅需极低功耗的芯片,有望在不牺牲能力的前提下解决可持续性问题。

展望未来,团队认为其模拟计算方法有望适配其他具有挑战性的AI工作负载。"这只是开始,"孙仲表示,"当我们跳出传统数字范式时,已经展示了无限可能。"

关键要点:

- 能效突破:新芯片功耗仅为现有方案的1/228

- 速度优势:NMF任务处理比数字芯片快12倍

- 存储优化:图像压缩空间需求减半

- 实战验证:已在推荐系统和图像处理中展现成效

- 论文发表:研究成果刊载于1月19日《自然·通讯》