北京大学芯片突破大幅降低AI能耗需求

北京大学团队以突破性芯片重新定义AI效率

随着人工智能系统日益复杂,其对计算能力的渴求正变得难以持续。但北京大学人工智能学院的研究人员可能找到了改变游戏规则的解决方案。

AI计算中的能源困境

由孙忠研究员领导的团队解决了一个根本性问题:传统数字芯片难以应对现代AI应用所需的大规模计算。"在处理实时大规模数据时,"孙忠解释道,"数字芯片在计算复杂性和内存访问限制方面都会遇到瓶颈。"

他们的创新方法?转向模拟计算技术。新芯片不再仅依赖数字处理,而是利用物理定律直接进行并行计算。这种根本性转变从硬件层面降低了延迟和功耗。

令人瞩目的实际性能表现

这项突破的数字说明了一切:

- 相比先进数字芯片处理速度快12倍

- 能效提升228倍——对可持续AI发展具有革命性意义

- 在图像压缩任务中保持高精度的同时仅需一半存储空间

- 在推荐系统训练方面显著优于传统硬件

其影响深远:想象流媒体服务能以当前能耗的一小部分即时提供个性化推荐,或医疗成像系统在不使服务器过热的情况下处理高清扫描图像。

实验室之外的重大意义

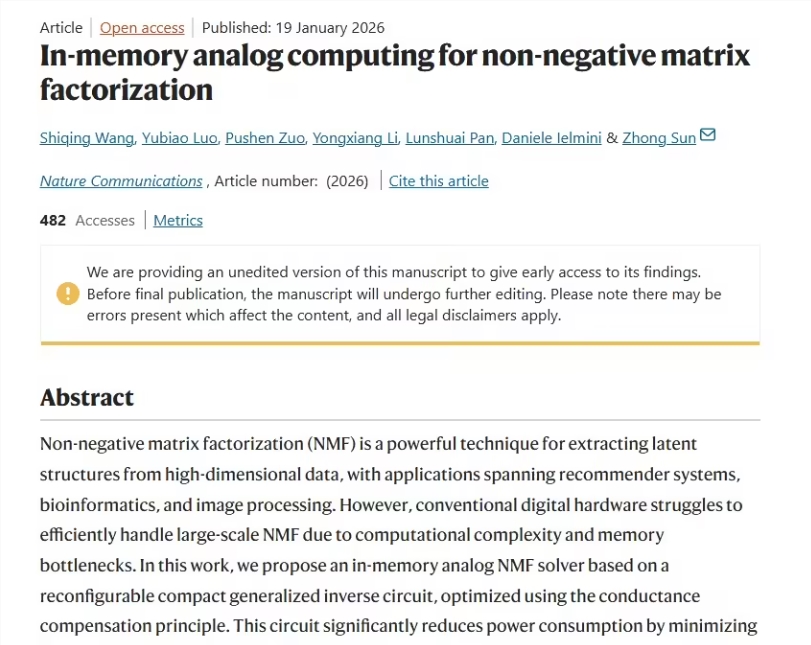

这项发表于1月19日《自然·通讯》的研究展示了模拟计算如何以前所未有的效率处理现实世界中的复杂数据。孙忠看到了广阔的应用前景:"从实时推荐到高清图像处理,这项技术打开了我们此前无法想象的大门。"

时机再好不过了。随着全球对技术环境影响的担忧加剧,能以更低能耗提供更强算力的解决方案不仅是便利——它们对可持续技术进步至关重要。

关键要点:

- 模拟优势:基于物理定律的并行计算大幅削减能耗需求

- 性能提升:相比数字芯片速度最高提升12倍,能效提高228倍

- 实际应用:在图像压缩(节省50%空间)和推荐系统中表现卓越

- 发表研究:成果刊登于权威期刊《自然·通讯》

- 未来潜力:可能变革需要密集型实时数据处理的领域