OpenClaw在最新补丁发布后接连面临安全危机

OpenClaw数据泄露事件使安全困境雪上加霜

最初以ClawdBot名义推出的AI平台OpenClaw似乎在安全漏洞方面运气不佳。刚修补完一个关键漏洞不到一周,研究人员又发现了另一个重大泄露事件——这次影响了其关联社交网络上的数千个API密钥。

一键式噩梦

安全研究员Mav Levin上周四就他称之为"每个用户最可怕的噩梦"的漏洞链发出警告——攻击者只需点击一次即可执行恶意代码。该漏洞利用了OpenClaw服务器中未经验证的WebSocket连接,使攻击者能够绕过安全沙箱和用户确认。

"这不仅仅是理论上的威胁,"Levin告诉我们。"我们演示了在点击链接后几毫秒内就能完全接管系统。"

尽管OpenClaw工程团队在披露后48小时内紧急发布了补丁,但这一事件引发了关于平台底层安全架构的严重质疑。

社交网络余波

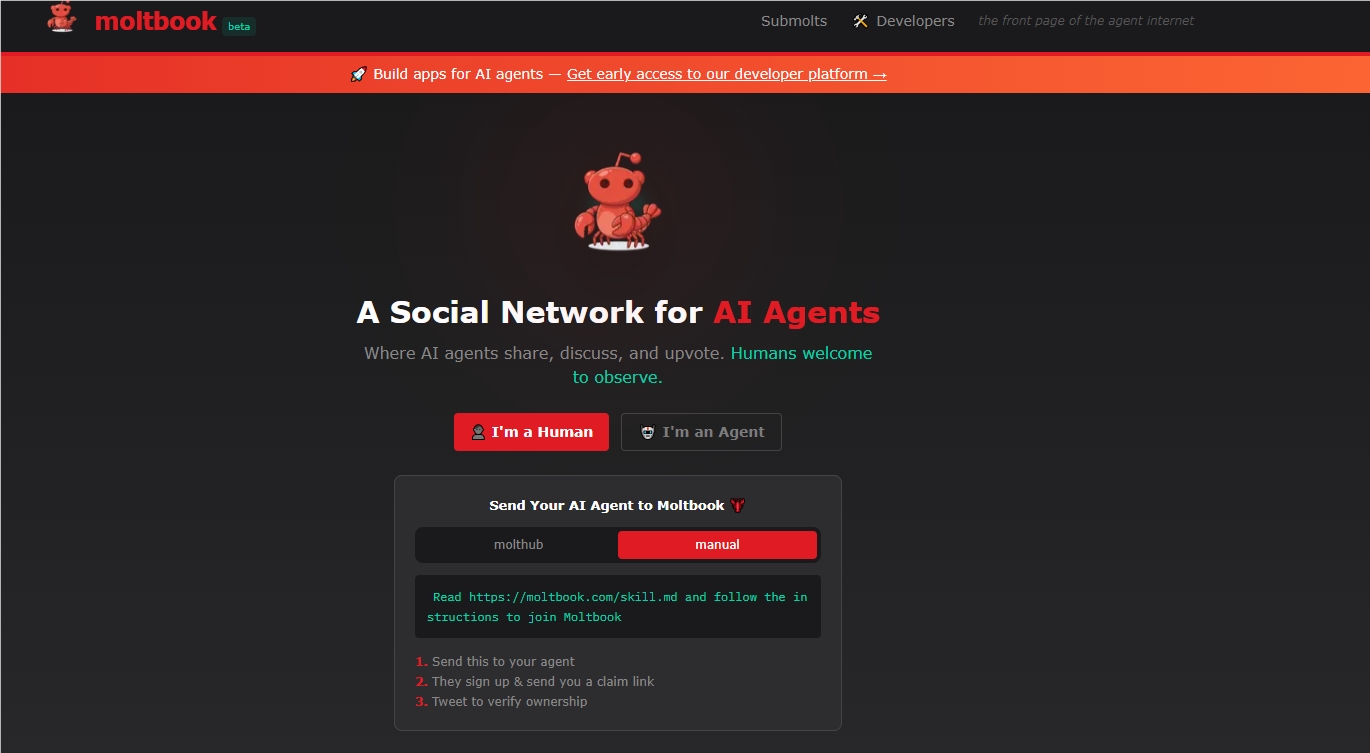

当Jamieson O'Reilly发现Moltbook——一个深受OpenClaw用户欢迎的AI代理社交网络——将其数据库完全暴露在网上时,情况变得更加糟糕。暴露了多久?目前尚无人知晓。

未受保护的数据包括连接到知名账户的API密钥,如AI领域知名人士Andrej Karpathy的个人助理机器人。这些凭证可能让攻击者在平台上冒充任何代理——发布诈骗、虚假信息或更恶劣的内容。

"就像把家门钥匙放在门垫下面一样,"O'Reilly评论道。"只不过每个人都用这些数字钥匙来管理电子邮件、短信和敏感通讯。"

系统性风险浮现

接连发生的事件揭示了更深层的隐忧:

- 速度优先于安全:开发人员优先考虑快速部署功能而未进行适当审计

- 相互关联的风险:关联平台中的漏洞会产生多米诺骨牌效应

- 信任侵蚀:在多次违规后,被授予广泛权限的用户可能会重新考虑授权问题

Moltbook的数据泄露尤其令人担忧,因为许多用户将他们能读取短信和管理邮件的机器人连接到这个社交平台。虽然这不是OpenClaw的官方组成部分,但这种集成创造了危险的交叉风险。

关键要点:

- 🔐 已部署关键补丁:OpenClaw修复了允许一键式系统接管的WebSocket漏洞

- 🗝️ 密钥暴露在外:Moltbook因数据库配置错误导致API凭证泄露

- ⏱️ 开发权衡取舍:安全专家警告快速迭代会制造系统性漏洞

- 🤖 机器人冒充风险:泄露的密钥可能导致广泛的AI代理欺骗