OpenAI的GPT-OSS-20B可在骁龙设备上本地运行

OpenAI与高通携手实现GPT-OSS-20B本地AI处理

OpenAI发布了其最新的开源语言模型GPT-OSS-20B,该模型具有200亿参数。与OpenAI的O3-mini基准测试对比显示,该模型展现出强大的推理能力。在一项突破性声明中,高通透露GPT-OSS-20B是首个能在骁龙平台设备上本地运行的开源推理模型。

图片来源说明:该图片由AI生成,图片授权服务商为Midjourney。

从云端到本地的转变

历史上,OpenAI的复杂模型需要云端部署,用户必须保持稳定的网络连接。通过与高通合作,GPT-OSS-20B现在可以直接在骁龙设备上进行本地推理。这一进步消除了网络速度造成的延迟问题,同时通过减少数据传输到外部服务器来增强隐私保护。

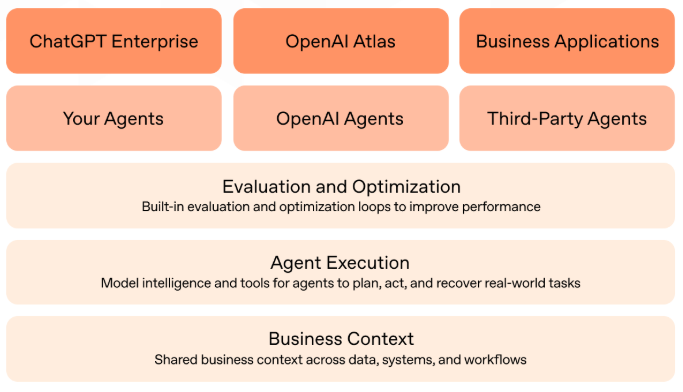

高通在模型优化中的作用

高通将GPT-OSS-20B预集成至其高通AI栈中,验证了该模型在终端设备上的性能表现。这一里程碑标志着AI技术的重大转变,使得复杂推理任务能够在本地执行,而不再完全依赖云端基础设施。此举不仅提升了用户体验,还为开发者和合作伙伴开辟了新途径。

开发者的可访问性

开发者可以通过Hugging Face和Ollama等热门平台访问GPT-OSS-20B。后者提供Turbo模式,让用户无需复杂配置即可探索模型功能。高通计划通过Qualcomm AI Hub发布更多部署资源,助力开发者充分挖掘模型潜力。

GPT-OSS-20B的发布标志着向更成熟AI生态系统迈出了重要一步。合作伙伴和开发者现在可以利用骁龙处理器实时集成OpenAI的创新成果,加速智能应用的开发进程。

关键要点:

🌟 本地执行: GPT-OSS-20B原生支持骁龙设备运行,降低云端依赖 ⚡️ 性能与隐私: 为用户提供更快响应速度和更强数据安全保障 🚀 开发者友好: 可通过Hugging Face和Ollama实现无缝集成