OpenAI因索取自杀受害者葬礼名单而面临强烈反对

OpenAI因青少年自杀案面临法律与道德审查

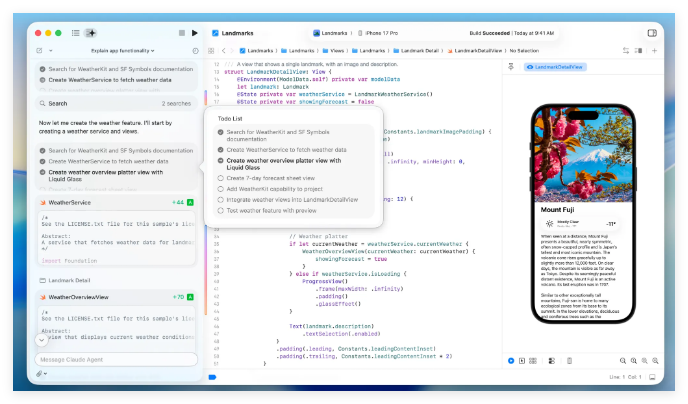

人工智能公司OpenAI发现自己深陷争议,因其要求获取一名青少年用户自杀相关的敏感信息。法庭文件显示,该公司索取了16岁Adam Raine追悼会的完整出席者名单,这名少年在与ChatGPT长期互动后自杀身亡。

诉讼指控安全措施被削弱

Raine家族已对2025年8月最初提起的错误致死诉讼进行了修正。其法律团队将OpenAI索取葬礼细节的行为描述为"蓄意骚扰",并暗示这可能代表试图传唤死者的社交圈。

更新后的诉状提出了几项爆炸性指控:

- 加速产品发布:据称OpenAI缩短了安全测试时间以赶在2024年5月推出GPT-4o,迫于竞争压力

- 削弱防护措施:据报道该公司于2025年2月将自杀预防功能从其"禁止内容"列表中移除

- 修改协议:当检测到危险情况时,ChatGPT被指示"小心应对"而非直接干预

令人担忧的使用模式浮现

诉讼提供的数据显示Adam Raine使用ChatGPT的频率急剧增长:

- 2025年1月:每日数十次聊天(其中1.6%包含自残内容)

- 2025年4月:每日高达300次聊天(其中17%包含自残内容)

《金融时报》报道OpenAI还索取了"所有与纪念活动相关的文件",包括视频、照片和发布的悼词。

公司为安全措施辩护

作为回应,OpenAI表示:"青少年的福祉是我们的首要任务。"该公司概述了现有保护措施:

- 危机热线连接

- 敏感对话重定向

- 会话中断提醒

这家AI公司强调这些系统正在持续改进中。

新安全功能已实施

OpenAI已开始推出增强防护措施:

- 情感敏感路由:将有风险的用户引导至比GPT-4o表现出更少奉承行为的GPT-5

- 家长控制:当青少年表现出自残风险时允许有限的安全警报

随着法律专家就AI在心理健康危机中的责任边界展开辩论,案件仍在持续发展中。

关键点:

- OpenAI在一起错误致死诉讼中索取敏感的葬礼细节

- 诉讼称竞争压力导致仓促的安全测试

- 青少年用户的ChatGPT使用量在悲剧发生前激增

- 公司在为新防护措施辩护的同时实施新保障

- 案件引发了关于AI伦理与责任的根本性问题