MiniMax开源M2 AI模型:以竞争对手8%的成本实现高效能

MiniMax发布具有行业领先效率的开源M2 AI模型

2025年10月27日,中国AI初创公司MiniMax宣布开源其M2大语言模型,将其定位为专有解决方案的高性价比替代品。该模型在编程任务和智能体工作流方面表现尤为突出,运营成本据称仅为Anthropic的Claude Sonnet等同类模型的8%。

技术规格与架构

M2模型采用总计2300亿参数的混合专家(MoE)架构,但在推理时仅激活100亿参数。这一设计选择在保持性能的同时显著降低了计算成本。关键技术特性包括:

- 204,800 token上下文窗口

- 131,072 tokens的最大输出容量

- 针对长时间任务处理的优化

性能基准测试

由Artificial Analysis进行的独立测试显示,M2在多项指标上位居开源模型首位,包括:

- 数学能力

- 科学推理

- 指令遵循

- 编程熟练度

- 智能体工具使用

据报道,该模型在数学和编程任务上的表现甚至优于Claude3 Opus等部分闭源替代方案,同时保持适合实时应用的低延迟。

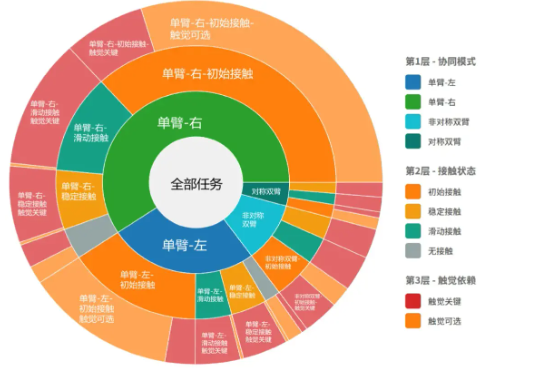

专项能力

M2在以下两个领域展现出特殊优势:

编程优化

该模型擅长:

- 代码生成

- 多文件编辑

- 编译-运行-修复循环

- 测试验证 与Claude Code和Cursor等开发者工具的无缝集成增强了其实用性。

智能体性能

该架构能可靠处理复杂工作流,包括:

- 多云平台操作

- Shell命令执行

- 浏览器交互 基准测试显示其在信息检索任务中表现卓越,并具备强大的故障恢复机制。

许可与可用性

该公司已根据宽松的Apache 2.0许可证发布M2,鼓励商业使用和修改。当前访问选项包括:

- MiniMax智能体平台和API提供的限时免费使用

- Hugging Face上提供的模型权重供本地部署 社区报告表明,相比某些专有替代方案,该模型在处理敏感查询时具有更强的事实可靠性。

模型权重可在以下地址获取:Hugging Face仓库 文档参见:MiniMax平台文档

关键点:

|--|--|

| Feature | Benefit |

| MoE Architecture | Efficient parameter activation (10B/230B) |

| Large Context Window | Handles complex, long-duration tasks |

| Open Licensing | Commercial use and modification permitted |