Meta语音技术重大突破:现可理解1600种语言

Meta用新AI工具弥合全球语言鸿沟

在包容性技术的重大飞跃中,Meta的基础人工智能研究(FAIR)团队推出了Omnilingual ASR,这是一个能够理解1600种语言口语的自动语音识别系统。其非凡之处在于?其中约有500种语言此前从未被任何AI系统处理过。

打破语言障碍

数字世界长期以来一直偏爱广泛使用的语言,使数千个语言社区被抛在后面。虽然大多数语音识别工具专注于数百种主流语言,但Omnilingual ASR旨在彻底改变这一局面。

"我们正在朝着可能成为通用转录系统的方向迈进," Meta的公告解释道。其影响深远——从保护濒危语言到为偏远社区提供数字访问能力。

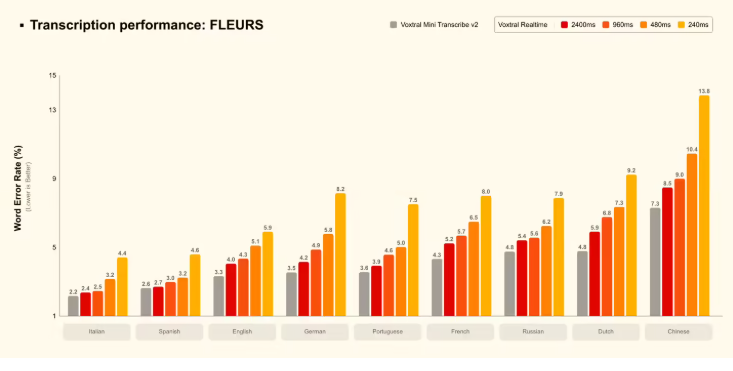

它的准确度如何?

该系统的性能基于可用的训练数据而有所不同:

- 78%的测试语言的字符错误率低于10%

- 仅需10小时的训练音频,95%的语言即可达到这一准确标准

- 即使是低资源语言(少于10小时的音频),也有36%的时间能达到低于10%的错误率

Meta随发布推出了Omnilingual ASR语料库,以Creative Commons许可发布了350种代表性不足的语言的转录语音样本。这一丰富的语言数据宝库使全球开发者能够为其社区定制解决方案。

"即插即用"的创新功能

一项突出的功能彻底改变了适配方式:

- 用户提供极少的配对音频/文本样本

- 系统直接学习而无需重新训练

- 无需大量计算资源

这种方法理论上可以将覆盖范围扩展到超过 5,400种语言,尽管Meta承认对于支持较少的语言,质量仍需改进.

开放获取理念

秉承其研究使命,Meta将Omnilingual ASR发布为:

- 完全开源(Apache 2.0许可证)

- 可用于商业用途

- 提供从轻量级(3亿参数)到高精度(70亿参数)的不同版本

该技术基于Meta的PyTorch框架构建,可通过其官方门户访问实时演示.

关键要点:

- 🌍 历史性规模:首个覆盖1600+语言的AI系统(新增500种)

- 🎯 实用准确度:即使在训练数据有限的情况下也能表现良好

- 🔓 开放生态系统:数据集和模型免费供社区开发使用

- ⚡️ 易于适配:'即插即用'降低了支持新语言的障碍