Jan全新AI模型在长期任务中超越Google Gemini

Jan突破性AI模型树立可靠性新标杆

在这场创造不仅能思考、更能可靠行动的AI竞赛中,开源团队Jan凭借最新发布的产品领先一步。Jan-v2-VL-Max不仅是又一个大型语言模型——它专门设计用于解决人工智能最令人沮丧的局限之一:在执行长期任务时偏离轨道的倾向。

解决"误差雪球"问题

任何使用过AI助手的人都深有体会——流程初期的小错误会逐渐累积成后期的完全失败。当前的多模态代理尤其不擅长处理自动化UI操作或跨应用工作流等长序列任务。Jan团队将这种现象称为"误差累积",即微小偏差演变成重大脱轨。

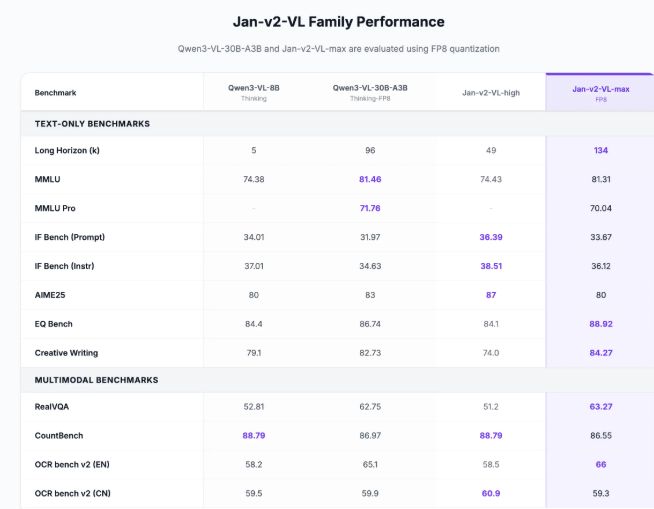

他们的解决方案?一项名为RLVR(强化长视距视觉语言推理)技术的巧妙改进。基于LoRA架构构建的这一创新在保留Qwen3-VL-30B基础模型能力的同时,显著提升了连贯性。结果如何?一个能准确完成数十个步骤而不迷失方向的AI。

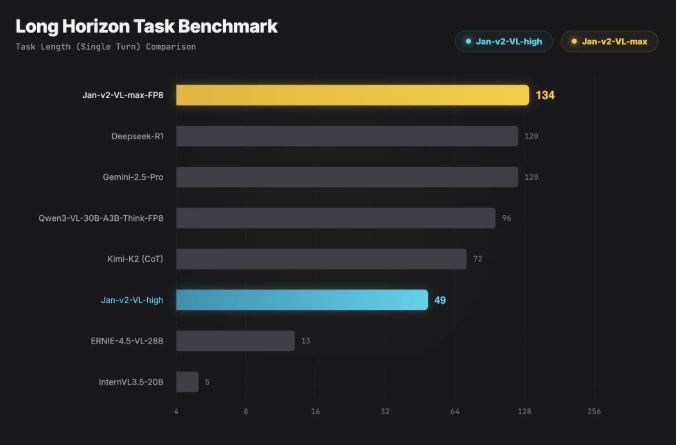

打破基准测试的表现

专业测试证明了这一点。在衡量AI长时间任务性能衰减的"幻觉衰减回报"(HDR)基准测试中,Jan-v2-VL-Max让竞争对手望尘莫及。它在其他模型表现不稳时保持稳定,不仅超越了Google的Gemini 2.5 Pro,还胜过DeepSeek R1。

为实际应用而设计

Jan团队不仅打造了令人印象深刻的技术——还使其易于使用:

- 网页界面:无需编码即可上传图像并测试多步骤流程

- 本地部署:优化的vLLM解决方案可在消费级GPU上高效运行

- 集成就绪:开发者可轻松将其整合到现有系统中

这对UI自动化、机器人技术和多工具协作等领域意义重大。

为何此刻至关重要

当AI从炫目的演示转变为日常工具时,可靠性变得至关重要。在其他竞争者追逐吸引眼球的功能时,Jan专注于在最关键时刻提供真正可靠的AI技术。

该模型不仅是技术成就——更标志着优先级的转变:从"智能"到"稳定",从花哨的单次响应到值得信赖的持续表现。

关键要点:

- 300亿参数多模态模型擅长长期任务

- 解决了困扰当前AI代理的"误差累积"问题

- 在稳定性基准测试中超越Google Gemini 2.5 Pro

- 提供网页界面和高效的本地部署方案

- 标志着向可靠性导向的AI开发转型