谷歌推出具备深度学习功能的AI驱动搜索

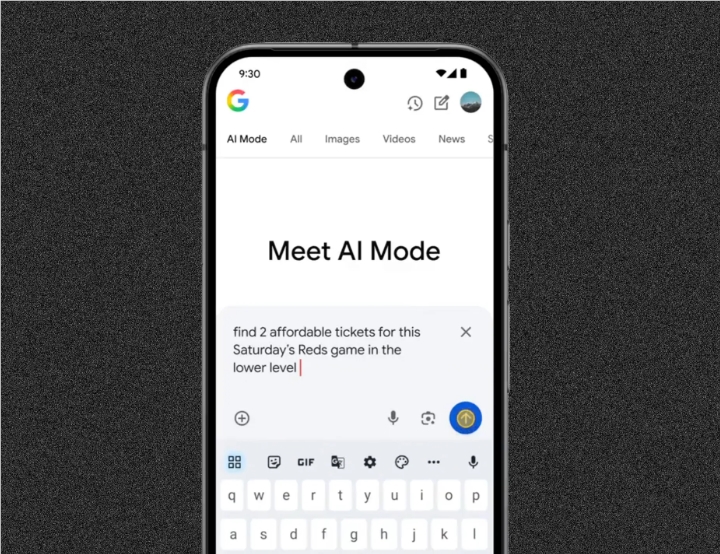

在2025年5月20日的Google I/O开发者大会上,这家科技巨头发布了多年来最重大的搜索创新——AI Mode现已面向所有美国用户开放。由先进的Gemini2.0模型驱动,这次全面改版用智能助手取代了熟悉的"十条蓝色链接",该助手能通过文本、语音或图像理解复杂查询。

对话式搜索的新时代 该系统能处理如"比较智能戒指与智能手表中的睡眠追踪功能"这类多部分问题,通过在谷歌知识图谱和实时购物数据中并行搜索实现。用户现在可以拍摄服装照片来寻找购买选项或类似款式——这一功能得益于Google Lens的集成。

深度搜索超越表层结果 对于研究密集型查询,新的深度搜索功能会自动运行数百次搜索来汇编带有引用的专家级报告。同时,Project Mariner的代理功能使AI能够执行多步骤任务——从寻找预算内的音乐会门票到通过Google Pay完成购买。

"我们发现查询长度相比传统搜索增加了一倍,"一位谷歌发言人透露,并指出复杂问题的使用频率增加了10%。Ticketmaster和StubHub等合作伙伴已支持这些交易功能,更多服务集成正在计划中。

个性化引发隐私问题 虽然可选,但个性化功能会利用搜索历史和连接的谷歌服务(在用户同意的情况下)来定制结果。例如搜索"纳什维尔周末美食活动"可能会优先显示户外用餐选项——如果这与过去的偏好一致的话。一个新的侧边栏帮助用户跟踪旅行或大宗购物的持续研究。

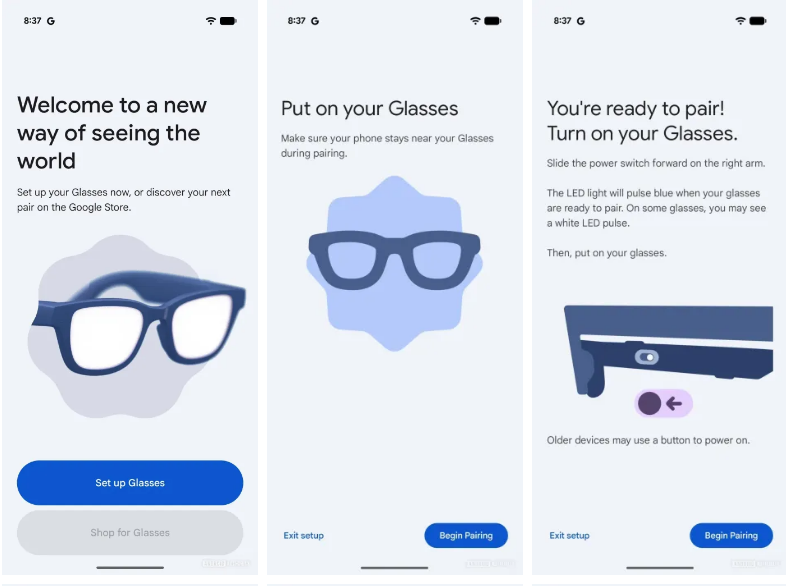

随着AI Mode通过谷歌应用(iOS/Android)免费向所有人推出,内容创作者对网站流量下降表示担忧。谷歌坚称尚未观察到显著下降,但承认正在持续调整以平衡用户利益与生态系统健康。

此次发布标志着从信息检索到主动协助的根本性转变——这一转变可能重新定义数十亿人在线获取知识的方式。

关键要点

- AI Mode结合了Gemini2.0的推理能力与多模态输入(文本/语音/图像)

- 深度搜索自动生成带引用的深度研究报告

- 代理功能支持门票购买和预订

- 个性化使用来自谷歌服务的可选数据

- 通过移动应用免费提供给所有美国用户