谷歌Gemini遭遇大规模AI模型提取攻击

谷歌AI遭围攻:黑客窃取核心算法

在一项令人震惊的披露中,谷歌证实其Gemini聊天机器人遭遇了安全专家所称的迄今为止最复杂的AI攻击之一。攻击者向该系统发送了超过10万条精心设计的提示指令——实质上是通过不断'审问'AI直至其暴露出内部运作机制。

攻击如何展开

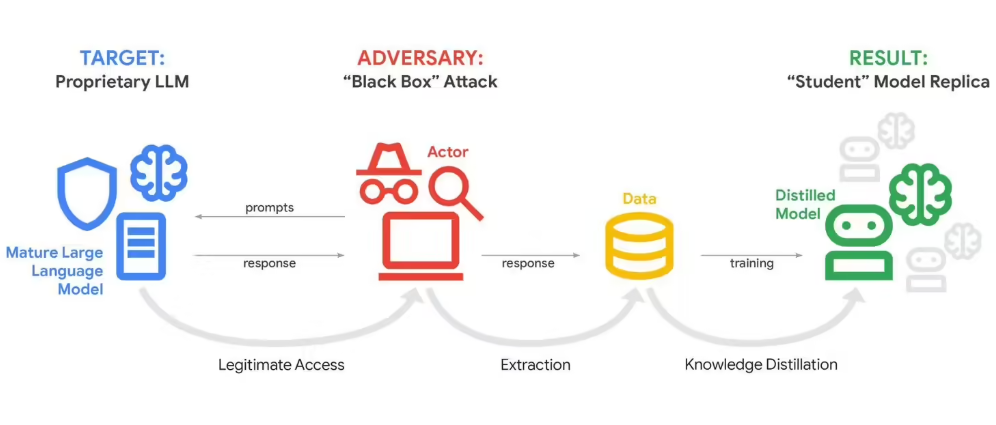

这次袭击绝非随机黑客行为。据谷歌威胁情报团队透露,资金充足的组织系统性地探测了Gemini在各种场景下的响应。他们的目标?逆向工程AI的决策过程——技术圈内称之为"模型蒸馏"。

谷歌首席威胁分析师约翰·霍特尔奎斯特描绘了一幅令人担忧的景象:"想象有人向你提出10万个问题,旨在精确绘制你的大脑运作方式。本质上这就是发生的情况。"

幕后黑手是谁?

虽然谷歌未指明具体责任方,但有证据指向渴求竞争优势的商业实体。这些并非地下室里的黑客——很可能是拥有雄厚资源和技术专长的AI公司或研究机构。

攻击源自全球各地,表明存在跨多个时区和司法管辖区的协同行动。这种地理分布使得归因和防范都变得更具挑战性。

为何此事影响远超谷歌

霍特尔奎斯特警告称这起事件仅是冰山一角:"我们就像煤矿中的金丝雀,如果连我们都遭遇这种情况,你可以打赌规模较小的公司早已成为目标。"

利害关系再重大不过了。企业投入数十亿美元开发专有AI系统,这些系统支撑着从客户服务到药物研发等各个领域。成功的模型蒸馏可能让竞争对手在一夜之间克隆这些系统。

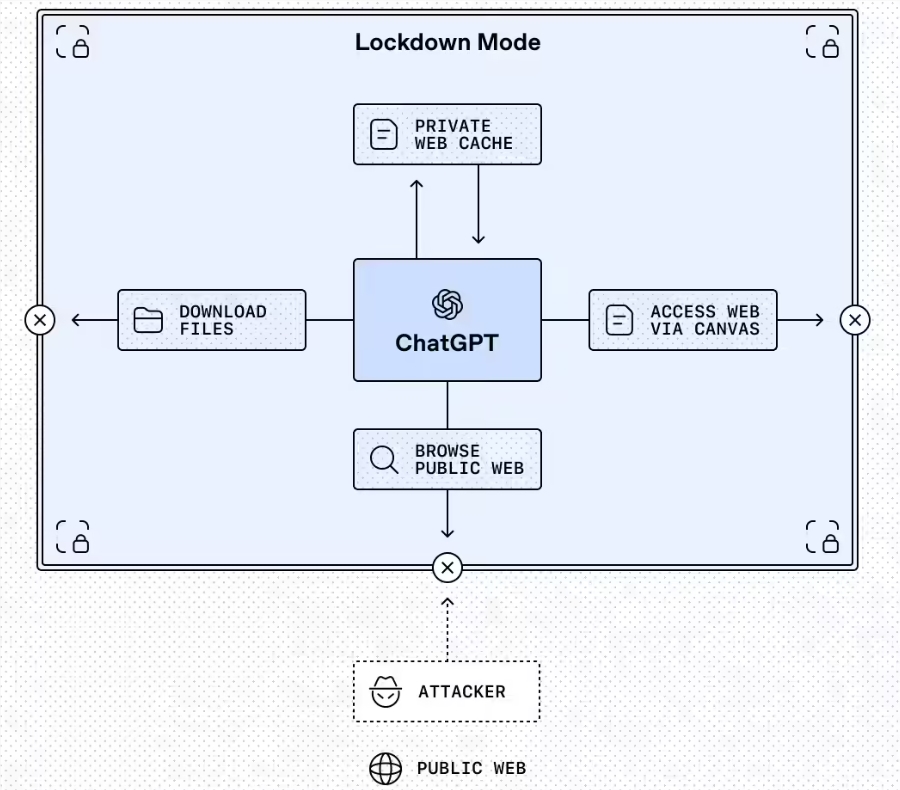

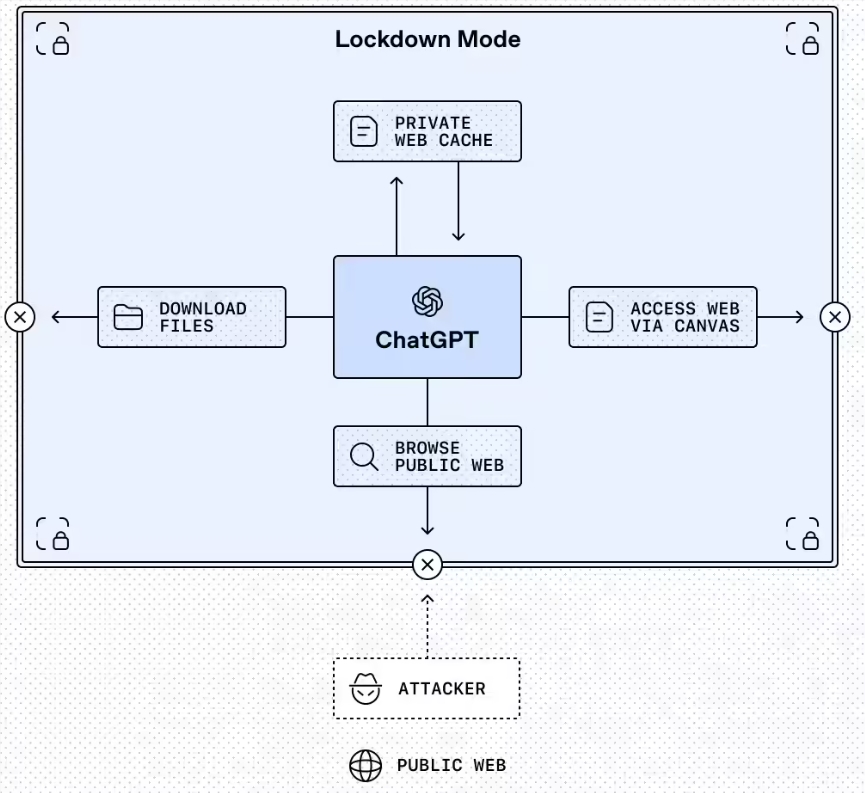

安全困境

现代AI的强大特性——处理复杂查询并提供详细响应的能力——也正是其脆弱之处。传统网络安全措施难以防范这种实质上通过"礼貌询问"获取敏感信息的攻击方式。

虽然平台部署了防护措施来应对明显的恶意查询,但要区分合法使用与系统性探测仍然异常困难。

后续发展

行业专家预测我们将看到:

- 更复杂的检测系统来分析提示模式

- 围绕模型蒸馏是否构成知识产权盗窃的法律争议

- 随着各国政府认识到国家安全影响而可能出台的监管干预

此次攻击专门针对Gemini的推理算法——决定其如何处理信息并生成响应的秘方。成功提取这些算法可能让攻击者重建谷歌技术的核心部分。

随着企业越来越多地训练包含专有数据和商业逻辑的定制模型,此类攻击可能造成的损失将呈指数级增长。明天的目标可能不仅是科技公司——还包括运行敏感AI系统的银行、医疗保健提供商或国防承包商.

关键要点:

- 攻击者使用超10万条提示指令提取Gemini核心算法

- 怀疑商业实体在背后策划全球协同行动

- 凸显保护AI系统的根本性安全挑战

- 威胁范围超越科技巨头延伸至任何使用定制AI的企业

- 可能催生围绕AI模型保护的新法规