Gemini遭遇围攻:黑客通过海量提示攻击窃取AI机密

谷歌就AI模型窃取计划拉响警报

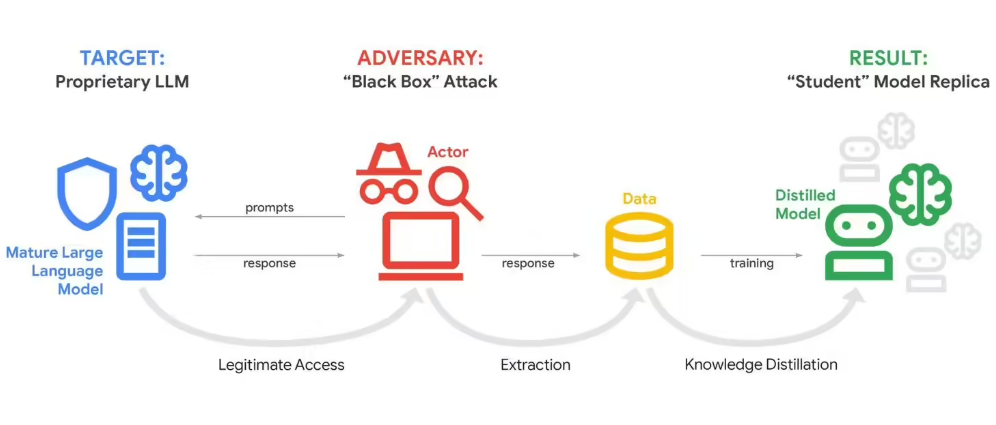

谷歌安全团队发现了一个令人不安的趋势——黑客正通过专家所称的"模型蒸馏攻击"系统地探测Gemini人工智能。与传统黑客手段不同,这些攻击者利用聊天机器人的本质特性,向其发送数十万条精心设计的提示。

"想象有人用100种不同方式问你同一个问题,"谷歌威胁情报主管John Hottelquist解释道,"最终会暴露出你的思维模式。本质上这就是正在发生的事,但达到了工业级规模。"

2月12日首次发现这些攻击时,谷歌注意到针对Gemini的异常活动模式。与可能提出几十甚至几百个问题的普通用户不同,这些攻击者系统性地提交了数万条查询,试图绘制出Gemini的内部逻辑图。

商业间谍视角

根据谷歌调查,这些数字攻击背后似乎是资金充足的组织——很可能是竞争对手AI公司或研究机构。他们的目标?要么克隆Gemini的能力,要么通过逆向工程其算法来提升自己的系统。

"这不仅仅是学术好奇心,"Hottelquist警告说,"我们谈论的是可能窃取价值数十亿美元开发成本的知识产权。"

虽然谷歌对具体嫌疑人守口如瓶,但这些攻击源自全球多个地点。最让安全团队担忧的是这种技术可能扩散开来。

AI安全的警钟

谷歌将其经历比作煤矿中的金丝雀——预示着整个行业面临危险的早期指标。随着更多公司开发包含敏感商业数据的专有AI模型,它们都可能成为类似提取尝试的目标。

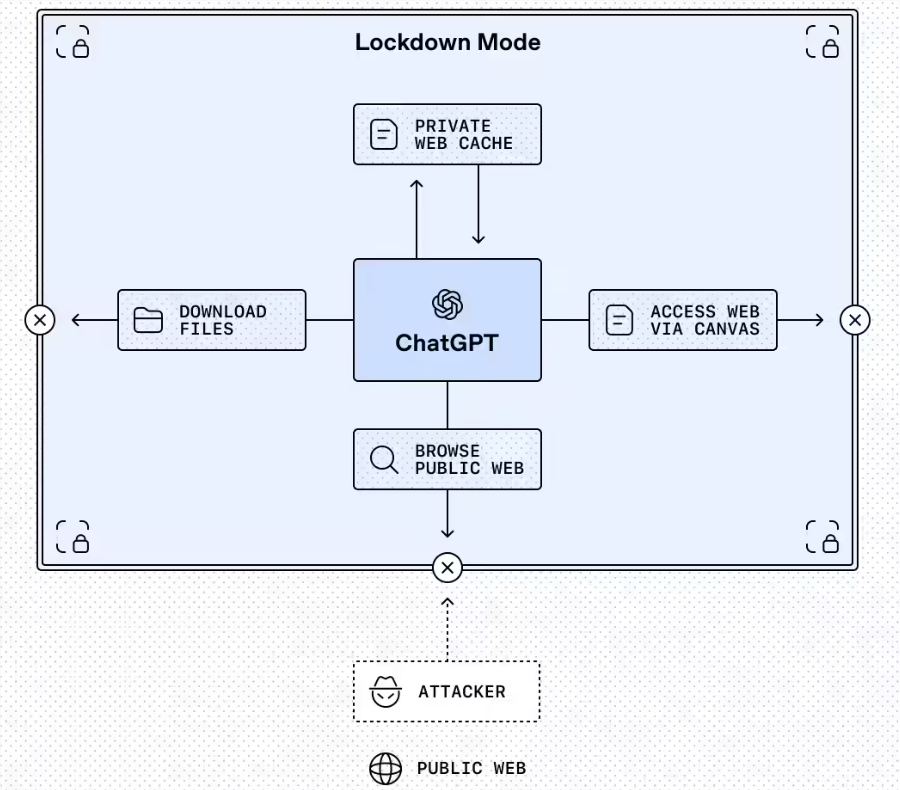

现有防御措施难以应对这些新型攻击,因为它们利用了大型语言模型运作的基本特性。虽然平台可以检测并阻止可疑活动模式,但在保持实用功能的同时完全防止此类探测仍是一个持续挑战。

攻击者似乎特别专注于揭露Gemini的推理算法——控制其处理信息并得出结论的秘密配方。成功提取这些算法可能让竞争对手无需投入原创研究就能复制关键能力。

关键点:

- 黑客使用海量提示(10万+)逆向工程Gemini的逻辑

- 攻击很可能由竞争对手公司/研究人员出于商业动机发起

- 该技术威胁价值数十亿美元的核心知识产权

- 警告随着定制AI模型激增带来的更广泛风险

- 由于模型固有的开放性导致当前防御措施有限